# Spring 云数据流参考 GUID

# 前言

# 1. 关于文档

此版本的文档可在HTML (opens new window)中找到。

可以找到 Spring 云数据流参考指南的最新副本here (opens new window)。

本文件的副本可供你自己使用并分发给他人,但前提是你不对此类副本收取任何费用,并且还需每一份副本均包含本版权声明,无论是以印刷形式还是以电子方式分发。

# 2. 获得帮助

云数据流有问题吗?我们愿意提供帮助!

问一个问题。我们监控stackoverflow.com (opens new window)中带有[

spring-cloud-dataflow]标记的问题(https://stackoverflow.com/tags/ Spring-cloud-dataflow)。在github.com/spring-cloud/spring-cloud-dataflow/issues (opens new window)处使用 Spring 云数据流报告错误。

在Gitter (opens new window)上与社区和开发人员聊天。

| 所有的云数据流都是开源的,包括文档!如果你在 DOCS 中发现问题 ,或者你只是想改进它们,请参与进来 (opens new window)。 |

|---|

# 开始

# 3. 开始-本地

有关设置 Docker Compose 和手动安装的更多信息,请参见 microSite 的本地机器 (opens new window)部分。

在本地安装了数据流服务器之后,你可能想要开始将现成的预构建应用程序部署到相干流或批处理数据管道中。我们有一些指南可以帮助你同时开始Stream (opens new window)和Batch (opens new window)处理。

# 4. 入门-Cloud Foundry

本节介绍如何在 Cloud Foundry 上开始使用 Spring 云数据流。有关在 Cloud Foundry 上安装 Spring 云数据流的更多信息,请参见 microSite 的Cloud Foundry (opens new window)部分。

一旦在 Cloud Foundry 上安装了数据流服务器,你可能想开始着手将现成的预构建应用程序部署到连贯的流或批处理数据管道中。我们有一些指南可以帮助你同时开始Stream (opens new window)和Batch (opens new window)处理。

# 5. 开始-Kubernetes

Spring Cloud Data Flow (opens new window)是一个用于构建数据集成和实时数据处理管道的工具包。

管道由 Spring 引导应用程序组成,这些应用程序是用 Spring Cloud Stream 或 Spring Cloud Task 微服务框架构建的。这使得 Spring 云数据流适合一系列数据处理用例,从导入-导出到事件流和预测分析。

该项目提供了使用 Spring 云数据流的支持,Kubernetes 是这些管道的运行时,应用程序打包为 Docker 映像。

有关在 Kubernetes 上安装 Spring 云数据流的更多信息,请参见 microSite 的Kubernetes (opens new window)部分。

在 Kubernetes 上安装了数据流服务器之后,你可能想要着手将现成的预构建应用程序部署到一个连贯的流或批处理数据管道中。我们有一些指南可以帮助你同时开始Stream (opens new window)和Batch (opens new window)处理。

# 5.1.应用程序和服务器属性

本节介绍如何定制应用程序的部署。你可以使用许多属性来影响部署的应用程序的设置。属性可以在每个应用程序的基础上应用,也可以在所有已部署应用程序的适当服务器配置中应用。

| 在每个应用程序的基础上设置的属性总是优先于作为服务器配置设置的属性。这种安排使你可以在每个应用程序的基础上重写全局服务器级别的属性。 |

|---|

要为所有部署的任务应用的属性在src/kubernetes/server/server-config-[binder].yaml文件中定义,在src/kubernetes/skipper/skipper-config-[binder].yaml中为流定义。将[binder]替换为你正在使用的消息传递中间件——例如,rabbit或kafka。

# 5.1.1.内存和 CPU 设置

应用程序使用默认的内存和 CPU 设置进行部署。如果需要,可以调整这些值。下面的示例显示了如何将Limits设置为1000m,对于内存为CPU,将1024Mi设置为Requests,对于 CPU 为800m,对于内存为640Mi:

deployer.<application>.kubernetes.limits.cpu=1000m

deployer.<application>.kubernetes.limits.memory=1024Mi

deployer.<application>.kubernetes.requests.cpu=800m

deployer.<application>.kubernetes.requests.memory=640Mi

这些值将导致使用以下容器设置:

Limits:

cpu: 1

memory: 1Gi

Requests:

cpu: 800m

memory: 640Mi

你还可以控制全局设置cpu和memory的默认值。

下面的示例展示了如何为流设置 CPU 和内存:

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

limits:

memory: 640mi

cpu: 500m

下面的示例展示了如何为任务设置 CPU 和内存:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

limits:

memory: 640mi

cpu: 500m

到目前为止,我们使用的设置仅影响容器的设置。它们不会影响容器中 JVM 进程的内存设置。如果你想要设置 JVM 内存设置,那么你可以设置一个环境变量来这样做。有关详细信息,请参见下一节。

# 5.1.2.环境变量

要影响给定应用程序的环境设置,可以使用spring.cloud.deployer.kubernetes.environmentVariablesDeployer 属性。例如,生产设置中的一个常见要求是影响 JVM 内存参数。你可以通过使用JAVA_TOOL_OPTIONS环境变量来实现这一点,如下例所示:

deployer.<application>.kubernetes.environmentVariables=JAVA_TOOL_OPTIONS=-Xmx1024m

environmentVariables属性接受以逗号分隔的字符串。如果一个环境变量包含的值也是逗号分隔的字符串,那么它必须用单引号括起来——例如, spring.cloud.deployer.kubernetes.environmentVariables=spring.cloud.stream.kafka.binder.brokers='somehost:9092,<br/>anotherhost:9093' |

|---|

这将覆盖所需<application>的 JVM 内存设置(用应用程序的名称替换<application>)。

# 5.1.3.活性和准备状态探查

liveness和readiness探针分别使用称为/health和/info的路径。它们分别使用delay的10和period的60和10。在部署流时,可以使用 Deployer 属性更改这些默认值。活性和准备状态探测仅应用于流。

下面的示例通过设置部署程序属性来更改liveness探测(将<application>替换为应用程序的名称):

deployer.<application>.kubernetes.livenessProbePath=/health

deployer.<application>.kubernetes.livenessProbeDelay=120

deployer.<application>.kubernetes.livenessProbePeriod=20

可以将其声明为流的服务器全局配置的一部分,如下例所示:

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

livenessProbePath: /health

livenessProbeDelay: 120

livenessProbePeriod: 20

类似地,你可以将liveness交换为readiness,以覆盖默认的readiness设置。

默认情况下,端口 8080 被用作探测端口。可以使用 Deployer 属性更改liveness和readiness探测端口的默认值,如下例所示:

deployer.<application>.kubernetes.readinessProbePort=7000

deployer.<application>.kubernetes.livenessProbePort=7000

可以将其声明为流的全局配置的一部分,如下例所示:

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

readinessProbePort: 7000

livenessProbePort: 7000

默认情况下,liveness和readiness探测路径使用 Spring Boot2.x+actuator 端点。要使用 Spring Boot1.x 执行器端点路径,必须调整liveness和readiness值,如下面的示例所示(将<application>替换为应用程序的名称):<br/>deployer.<application>.kubernetes.livenessProbePath=/health<br/>deployer.<application>.kubernetes.readinessProbePath=/info<br/>在每个应用程序的基础上自动将 liveness和readiness端点都设置为默认的 Spring 引导 1.x 路径,你可以设置以下属性:r=“gt=”“606”/><593"/> |

|---|

你可以使用存储在Kubernetes 的秘密 (opens new window)中的凭据访问安全的探测端点。如果凭据包含在秘密的credentials块的data键名下,则可以使用现有的秘密。你可以在每个应用程序的基础上配置探测身份验证。启用后,将使用相同的凭据和身份验证类型将其应用于liveness和readiness探测端点。目前,只支持Basic身份验证。

创造一个新的秘密:

使用用于访问安全探测端点的凭据生成 base64 字符串。

基本身份验证将用户名和密码编码为

username:password格式的 base64 字符串。下面的示例(其中包括输出,你应该用你的值替换

user和pass)展示了如何生成 base64 字符串:$ echo -n "user:pass" | base64 dXNlcjpwYXNz使用编码的凭据,创建一个包含以下内容的文件(例如,

myprobesecret.yml):apiVersion: v1 kind: Secret metadata: name: myprobesecret type: Opaque data: credentials: GENERATED_BASE64_STRING将

GENERATED_BASE64_STRING替换为前面生成的 base64 编码的值。使用

kubectl创建秘密,如下例所示:$ kubectl create -f ./myprobesecret.yml secret "myprobesecret" created将以下部署人员属性设置为在访问探测端点时使用身份验证,如下例所示:

deployer.<application>.kubernetes.probeCredentialsSecret=myprobesecret将

<application>替换为要对其应用身份验证的应用程序的名称。

# 5.1.4.使用SPRING_APPLICATION_JSON

你可以使用SPRING_APPLICATION_JSON环境变量来设置数据流服务器属性(包括 Maven 存储库设置的配置),这些属性在所有数据流服务器实现中都是通用的。这些设置位于部署 YAML 的容器env部分的服务器级别。下面的示例展示了如何做到这一点:

env:

- name: SPRING_APPLICATION_JSON

value: "{ \"maven\": { \"local-repository\": null, \"remote-repositories\": { \"repo1\": { \"url\": \"https://repo.spring.io/libs-snapshot\"} } } }"

# 5.1.5.专用 Docker 注册表

你可以在每个应用程序的基础上从私有注册表中提取 Docker 映像。首先,你必须在集群中创建一个秘密。按照从私有注册表中提取图像 (opens new window)指南创建秘密。

创建了秘密之后,就可以使用imagePullSecret属性来设置要使用的秘密,如下例所示:

deployer.<application>.kubernetes.imagePullSecret=mysecret

将<application>替换为应用程序的名称,并将mysecret替换为前面创建的秘密的名称。

你还可以在全局服务器级别上配置图像提取秘密。

下面的示例展示了如何对流进行此操作:

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

imagePullSecret: mysecret

下面的示例展示了如何对任务执行此操作:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

imagePullSecret: mysecret

用前面创建的秘密的名称替换mysecret。

# 5.1.6.注解

你可以在每个应用程序的基础上向 Kubernetes 对象添加注释。支持的对象类型是 podDeployment、Service和Job。注释以key:value格式定义,允许用逗号分隔多个注释。有关注释的更多信息和用例,请参见注解 (opens new window)。

下面的示例展示了如何配置应用程序来使用注释:

deployer.<application>.kubernetes.podAnnotations=annotationName:annotationValue

deployer.<application>.kubernetes.serviceAnnotations=annotationName:annotationValue,annotationName2:annotationValue2

deployer.<application>.kubernetes.jobAnnotations=annotationName:annotationValue

用应用程序的名称和注释值替换<application>。

# 5.1.7.入口点样式

入口点样式会影响将应用程序属性传递给要部署的容器的方式。目前,支持三种样式:

exec(默认):将部署请求中的所有应用程序属性和命令行参数作为容器参数传递。应用程序属性被转换为--key=value的格式。shell:将所有应用程序属性和命令行参数作为环境变量传递。每个应用程序或命令行参数属性都被转换为大写字符串,并且.字符被替换为_。boot:创建一个名为SPRING_APPLICATION_JSON的环境变量,该变量包含所有应用程序属性的 JSON 表示。来自部署请求的命令行参数被设置为容器参数。

| 在所有情况下,在服务器级配置和每个应用程序的基础上定义的环境变量都会按原样发送到容器。 |

|---|

你可以按以下方式配置应用程序:

deployer.<application>.kubernetes.entryPointStyle=<Entry Point Style>

将<application>替换为应用程序的名称,并将<Entry Point Style>替换为所需的入口点样式。

你还可以在全局服务器级别配置入口点样式。

下面的示例展示了如何对流进行此操作:

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

entryPointStyle: entryPointStyle

下面的示例展示了如何对任务执行此操作:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

entryPointStyle: entryPointStyle

用所需的入口点样式替换entryPointStyle。

你应该选择exec或shell的入口点样式,以对应于在容器的ENTRYPOINT中定义ENTRYPOINT语法的方式。有关exec与shell的更多信息和用例,请参见 Docker 文档的ENTRYPOINT (opens new window)部分。

使用boot入口点样式对应于使用exec样式ENTRYPOINT。来自部署请求的命令行参数将传递给容器,添加的应用程序属性将映射到SPRING_APPLICATION_JSON环境变量中,而不是命令行参数。

当使用boot入口点样式时,deployer.<application>.kubernetes.environmentVariables属性不能包含SPRING_APPLICATION_JSON。 |

|---|

# 5.1.8.部署服务帐户

你可以通过属性为应用程序部署配置自定义服务帐户。你可以使用现有的服务帐户或创建新的服务帐户。创建服务帐户的一种方法是使用kubectl,如下例所示:

$ kubectl create serviceaccount myserviceaccountname

serviceaccount "myserviceaccountname" created

然后,你可以按以下方式配置各个应用程序:

deployer.<application>.kubernetes.deploymentServiceAccountName=myserviceaccountname

将<application>替换为应用程序的名称,并将myserviceaccountname替换为服务帐户的名称。

你还可以在全局服务器级别配置服务帐户名。

下面的示例展示了如何对流进行此操作:

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

deploymentServiceAccountName: myserviceaccountname

下面的示例展示了如何对任务执行此操作:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

deploymentServiceAccountName: myserviceaccountname

将myserviceaccountname替换为要应用于所有部署的服务帐户名称。

# 5.1.9.图像拉取策略

图像拉取策略定义了何时应该将 Docker 图像拉到本地注册中心。目前,有三项政策得到支持:

IfNotPresent(默认值):如果图像已经存在,请不要拉它。Always:无论图像是否已经存在,都要拉它。Never:永远不要拉图像。只使用已经存在的图像。

下面的示例展示了如何单独配置应用程序:

deployer.<application>.kubernetes.imagePullPolicy=Always

将<application>替换为应用程序的名称,并将Always替换为所需的图像拉出策略。

你可以在全局服务器级别配置一个映像拉出策略。

下面的示例展示了如何对流进行此操作:

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

imagePullPolicy: Always

下面的示例展示了如何对任务执行此操作:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

imagePullPolicy: Always

将Always替换为所需的图像拉出策略。

# 5.1.10.部署标签

你可以在与Deployment (opens new window)相关的对象上设置自定义标签。有关标签的更多信息,请参见Labels (opens new window)。标签以key:value格式指定。

下面的示例展示了如何单独配置应用程序:

deployer.<application>.kubernetes.deploymentLabels=myLabelName:myLabelValue

用应用程序的名称替换<application>,用标签名称替换myLabelName,用标签的值替换myLabelValue。

此外,你还可以应用多个标签,如下例所示:

deployer.<application>.kubernetes.deploymentLabels=myLabelName:myLabelValue,myLabelName2:myLabelValue2

# 5.1.11.公差

公差与污点一起工作,以确保 POD 不被调度到特定节点上。公差被设置到 POD 配置中,而污点被设置到节点上。有关更多信息,请参见 Kubernetes 引用的污点和公差 (opens new window)部分。

下面的示例展示了如何单独配置应用程序:

deployer.<application>.kubernetes.tolerations=[{key: 'mykey', operator: 'Equal', value: 'myvalue', effect: 'NoSchedule'}]

根据所需的容忍配置,将<application>替换为应用程序的名称和键值对。

你也可以在全局服务器级别配置容差。

下面的示例展示了如何对流进行此操作:

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

tolerations:

- key: mykey

operator: Equal

value: myvalue

effect: NoSchedule

下面的示例展示了如何对任务执行此操作:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

tolerations:

- key: mykey

operator: Equal

value: myvalue

effect: NoSchedule

根据所需的容忍配置替换tolerations键值对。

# 5.1.12.秘密参考文献

秘密可以被引用,它们的全部数据内容可以被解码,并作为单个变量插入到 POD 环境中。有关更多信息,请参见 Kubernetes 引用的将秘密中的所有键值对配置为容器环境变量 (opens new window)部分。

下面的示例展示了如何单独配置应用程序:

deployer.<application>.kubernetes.secretRefs=testsecret

你还可以指定多个秘密,如下所示:

deployer.<application>.kubernetes.secretRefs=[testsecret,anothersecret]

将<application>替换为应用程序的名称,并将secretRefs属性替换为应用程序环境和秘密的适当值。

你也可以在全局服务器级别配置秘密引用。

下面的示例展示了如何对流进行此操作:

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

secretRefs:

- testsecret

- anothersecret

下面的示例展示了如何对任务执行此操作:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

secretRefs:

- testsecret

- anothersecret

将secretRefs中的项替换为一个或多个秘密名称。

# 5.1.13.秘密密钥引用

秘密可以被引用,它们的解码值可以被插入到 POD 环境中。有关更多信息,请参见 Kubernetes 引用的使用秘密作为环境变量 (opens new window)部分。

下面的示例展示了如何单独配置应用程序:

deployer.<application>.kubernetes.secretKeyRefs=[{envVarName: 'MY_SECRET', secretName: 'testsecret', dataKey: 'password'}]

将<application>替换为应用程序的名称,并将envVarName、secretName和dataKey属性替换为应用程序环境和秘密的适当值。

你也可以在全局服务器级别配置密钥引用。

下面的示例展示了如何对流进行此操作:

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

secretKeyRefs:

- envVarName: MY_SECRET

secretName: testsecret

dataKey: password

下面的示例展示了如何对任务执行此操作:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

secretKeyRefs:

- envVarName: MY_SECRET

secretName: testsecret

dataKey: password

将envVarName、secretName和dataKey属性替换为适合你的秘密的值。

# 5.1.14.配置图引用

配置图可以被引用,其全部数据内容可以被解码,并作为单个变量插入到 POD 环境中。有关更多信息,请参见 Kubernetes 引用的将配置映射中的所有键值对配置为容器环境变量 (opens new window)部分。

下面的示例展示了如何单独配置应用程序:

deployer.<application>.kubernetes.configMapRefs=testcm

你还可以指定多个 ConfigMap 实例,如下所示:

deployer.<application>.kubernetes.configMapRefs=[testcm,anothercm]

将<application>替换为应用程序的名称,并将configMapRefs属性替换为应用程序环境和配置图的适当值。

你还可以在全局服务器级别配置配置配置映射引用。

下面的示例展示了如何对流进行此操作。编辑适当的skipper-config-(binder).yaml,使用相应的活页夹替换(binder):

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

configMapRefs:

- testcm

- anothercm

下面的示例展示了如何通过编辑server-config.yaml文件来完成任务:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

configMapRefs:

- testcm

- anothercm

将configMapRefs中的项替换为一个或多个秘密名称。

# 5.1.15.配置映射密钥引用

可以引用配置图并将其相关的键值插入到 POD 环境中。有关更多信息,请参见 Kubernetes 引用的使用配置图数据定义容器环境变量 (opens new window)部分。

下面的示例展示了如何单独配置应用程序:

deployer.<application>.kubernetes.configMapKeyRefs=[{envVarName: 'MY_CM', configMapName: 'testcm', dataKey: 'platform'}]

将<application>替换为应用程序的名称,并将envVarName、configMapName和dataKey属性替换为应用程序环境和配置图的适当值。

你还可以在全局服务器级别配置配置配置映射引用。

下面的示例展示了如何对流进行此操作。编辑适当的skipper-config-(binder).yaml,使用相应的活页夹替换(binder):

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

configMapKeyRefs:

- envVarName: MY_CM

configMapName: testcm

dataKey: platform

下面的示例展示了如何通过编辑server-config.yaml文件来完成任务:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

configMapKeyRefs:

- envVarName: MY_CM

configMapName: testcm

dataKey: platform

用配置映射的适当值替换envVarName、configMapName和dataKey属性。

# 5.1.16.POD 安全上下文

你可以配置 POD 安全上下文,以便在指定的 UID(用户 ID)或 GID(组 ID)下运行进程。当你不希望在缺省rootUID 和 GID 下运行进程时,这是很有用的。你可以定义runAsUser或fsGroup,并且可以将它们配置为一起工作。有关更多信息,请参见 Kubernetes 引用的安全环境 (opens new window)部分。

下面的示例展示了如何单独配置应用程序吊舱:

deployer.<application>.kubernetes.podSecurityContext={runAsUser: 65534, fsGroup: 65534}

将<application>替换为应用程序的名称,并将runAsUser和/或fsGroup属性替换为容器环境的适当值。

你也可以在全局服务器级别配置 POD 安全上下文。

下面的示例展示了如何对流进行此操作。编辑适当的skipper-config-(binder).yaml,使用相应的活页夹替换(binder):

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

podSecurityContext:

runAsUser: 65534

fsGroup: 65534

下面的示例展示了如何通过编辑server-config.yaml文件来完成任务:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

podSecurityContext:

runAsUser: 65534

fsGroup: 65534

用容器环境的适当值替换runAsUser和/或fsGroup属性。

# 5.1.17.服务端口

部署应用程序时,将使用8080的默认端口创建一个 Kubernetes 服务对象。如果设置了server.port属性,它将重写默认端口值。你可以在每个应用程序的基础上向服务对象添加额外的端口。你可以使用逗号分隔符添加多个端口。

下面的示例展示了如何为应用程序配置服务对象上的附加端口:

deployer.<application>.kubernetes.servicePorts=5000

deployer.<application>.kubernetes.servicePorts=5000,9000

将<application>替换为应用程序的名称和端口的值。

# 5.1.18.statefulset init 容器

当通过使用 statefulset 部署应用程序时,将使用 init 容器在 POD 中设置实例索引。默认情况下,使用的图像是busybox,你可以对其进行自定义。

下面的示例展示了如何单独配置应用程序吊舱:

deployer.<application>.kubernetes.statefulSetInitContainerImageName=myimage:mylabel

将<application>替换为应用程序的名称,并将statefulSetInitContainerImageName属性替换为适合你的环境的值。

你也可以在全局服务器级别配置 statefulset init 容器。

下面的示例展示了如何对流进行此操作。编辑适当的skipper-config-(binder).yaml,使用相应的活页夹替换(binder):

data:

application.yaml: |-

spring:

cloud:

skipper:

server:

platform:

kubernetes:

accounts:

default:

statefulSetInitContainerImageName: myimage:mylabel

下面的示例展示了如何通过编辑server-config.yaml文件来完成任务:

data:

application.yaml: |-

spring:

cloud:

dataflow:

task:

platform:

kubernetes:

accounts:

default:

statefulSetInitContainerImageName: myimage:mylabel

将statefulSetInitContainerImageName属性替换为适合你的环境的值。

# 5.1.19.init 容器

部署应用程序时,可以根据每个应用程序设置自定义的 init 容器。有关更多信息,请参阅 Kubernetes 引用的init 容器 (opens new window)部分。

下面的示例展示了如何为应用程序配置 init 容器:

deployer.<application>.kubernetes.initContainer={containerName: 'test', imageName: 'busybox:latest', commands: ['sh', '-c', 'echo hello']}

用应用程序的名称替换<application>,并设置适合 init 容器的initContainer属性的值。

# 5.1.20.生命周期支持

部署应用程序时,可以附加postStart和preStop生命周期处理程序 (opens new window)来执行命令。除了exec之外,Kubernetes API 还支持其他类型的处理程序。此功能可以扩展为在将来的版本中支持其他操作。要配置上面链接页中所示的生命周期处理程序,请使用以下属性键将每个命令指定为逗号分隔的列表:

deployer.<application>.kubernetes.lifecycle.postStart.exec.command=/bin/sh,-c,'echo Hello from the postStart handler > /usr/share/message'

deployer.<application>.kubernetes.lifecycle.preStop.exec.command=/bin/sh,-c,'nginx -s quit; while killall -0 nginx; do sleep 1; done'

# 5.1.21.额外的集装箱

在部署应用程序时,可能需要将一个或多个容器与主容器一起部署。这将允许你适应一些部署模式,例如 Sidecar 和 Adapter,以备多容器 POD 设置的情况。

下面的示例展示了如何为应用程序配置其他容器:

deployer.<application>.kubernetes.additionalContainers=[{name: 'c1', image: 'busybox:latest', command: ['sh', '-c', 'echo hello1'], volumeMounts: [{name: 'test-volume', mountPath: '/tmp', readOnly: true}]},{name: 'c2', image: 'busybox:1.26.1', command: ['sh', '-c', 'echo hello2']}]

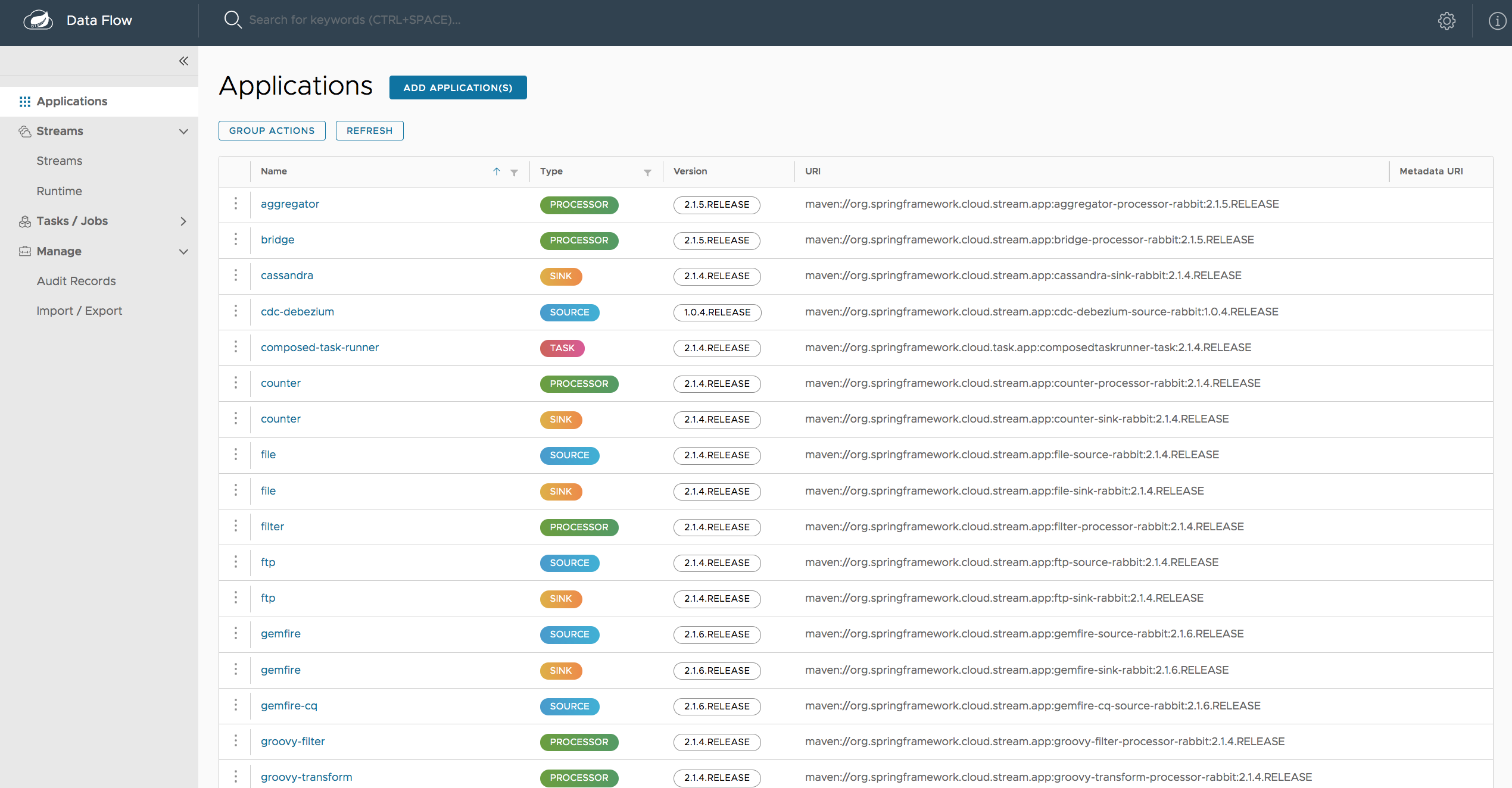

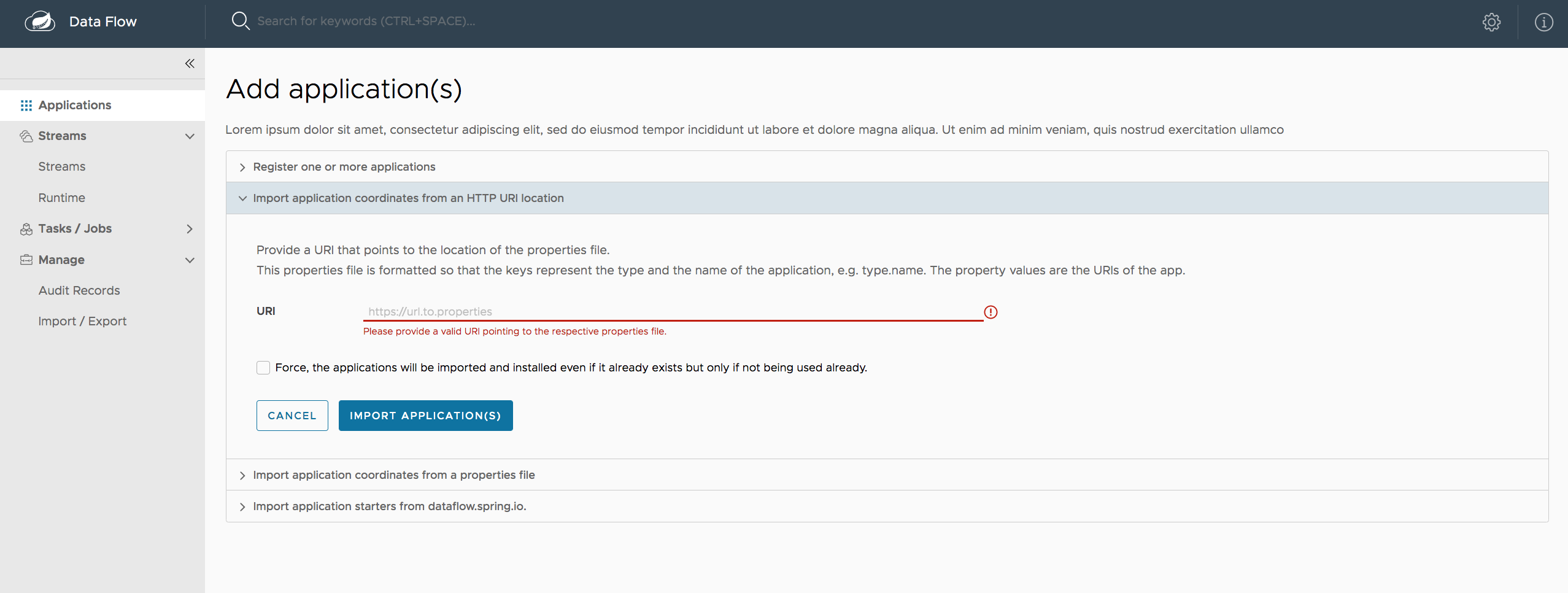

# 应用程序

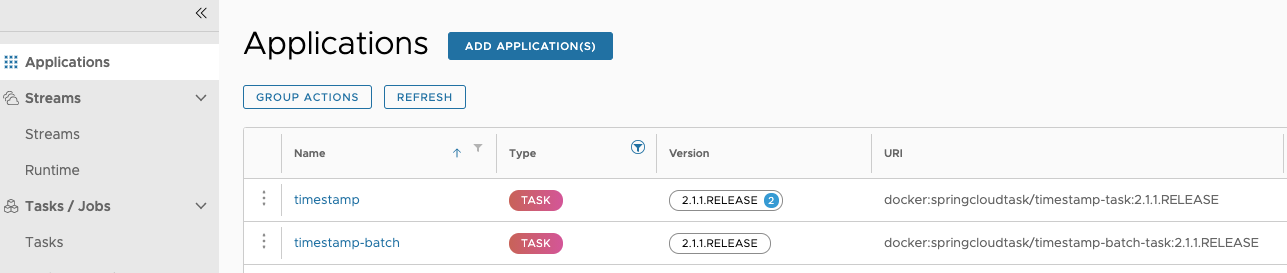

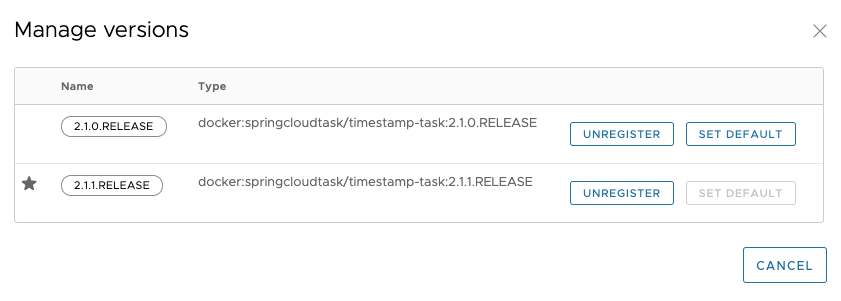

选择预构建的stream (opens new window)和任务或批处理 (opens new window)启动器应用程序,用于各种数据集成和处理场景,以促进学习和实验。下一节中的表格包括预先构建的应用程序,以供浏览。有关更多详细信息,请查看如何注册支持的应用程序。

# 6. 可用的应用程序

# 建筑

# 7. 导言

Spring 云数据流简化了专注于数据处理用例的应用程序的开发和部署。

微网站的建筑 (opens new window)部分描述了数据流的体系结构。

# 配置

# 8. Maven

如果希望覆盖特定的 Maven 配置属性(远程存储库、代理和其他属性)或在代理后面运行数据流服务器,则需要在启动数据流服务器时将这些属性指定为命令行参数,如以下示例所示:

$ java -jar spring-cloud-dataflow-server-2.9.2.jar --spring.config.additional-location=/home/joe/maven.yml

前面的命令假定为与下面类似的maven.yaml:

maven:

localRepository: mylocal

remote-repositories:

repo1:

url: https://repo1

auth:

username: user1

password: pass1

snapshot-policy:

update-policy: daily

checksum-policy: warn

release-policy:

update-policy: never

checksum-policy: fail

repo2:

url: https://repo2

policy:

update-policy: always

checksum-policy: fail

proxy:

host: proxy1

port: "9010"

auth:

username: proxyuser1

password: proxypass1

默认情况下,该协议被设置为http。如果代理不需要用户名和密码,则可以省略 auth 属性。另外,默认情况下, Maven localRepository被设置为${user.home}/.m2/repository/。如前面的示例所示,你可以指定远程存储库以及它们的身份验证(如果需要)。如果远程存储库位于代理之后,则可以指定代理属性,如前面的示例所示。

你可以为每个远程存储库配置指定存储库策略,如前面的示例所示。键policy既适用于snapshot,也适用于release存储库策略。

有关受支持的存储库策略列表,请参见存储库策略 (opens new window)主题。

因为这是 Spring boot@ConfigurationProperties,所以你需要通过将它们添加到SPRING_APPLICATION_JSON环境变量中来进行指定。下面的示例展示了 JSON 的结构:

$ SPRING_APPLICATION_JSON='

{

"maven": {

"local-repository": null,

"remote-repositories": {

"repo1": {

"url": "https://repo1",

"auth": {

"username": "repo1user",

"password": "repo1pass"

}

},

"repo2": {

"url": "https://repo2"

}

},

"proxy": {

"host": "proxyhost",

"port": 9018,

"auth": {

"username": "proxyuser",

"password": "proxypass"

}

}

}

}

'

# 8.1.马车

对于使用Wagon运输和 Maven 有一个有限的支持。目前,这是为了支持先发制人基于http的存储库的身份验证而存在的,并且需要手动启用。

通过将maven.use-wagon属性设置为true,可以启用基于 wagon 的http传输。然后,你可以为每个远程存储库启用先发制人身份验证。配置大致遵循HttpClient HTTP Wagon (opens new window)中的类似模式。在撰写本文时, Maven 自己网站中的文档有点误导性,并且缺少大多数可能的配置选项。

maven.remote-repositories.<repo>.wagon.http名称空间包含所有与 Wagonhttp相关的设置,它下面的键直接映射到受支持的http方法—即all,put,get和head,就像 Maven 自己的配置一样。在这些方法配置下,然后可以设置各种选项,例如use-preemptive。将带有所有请求的 auth 头发送到指定的远程存储库的 Simpl先发制人配置看起来像以下示例:

maven:

use-wagon: true

remote-repositories:

springRepo:

url: https://repo.example.org

wagon:

http:

all:

use-preemptive: true

auth:

username: user

password: password

与配置all方法不同,你可以只调整get和head请求的设置,如下所示:

maven:

use-wagon: true

remote-repositories:

springRepo:

url: https://repo.example.org

wagon:

http:

get:

use-preemptive: true

head:

use-preemptive: true

use-default-headers: true

connection-timeout: 1000

read-timeout: 1000

headers:

sample1: sample2

params:

http.socket.timeout: 1000

http.connection.stalecheck: true

auth:

username: user

password: password

这里有use-default-headers、connection-timeout、read-timeout、requestheaders和 httpclientparams的设置。有关参数的更多信息,请参见货车配置 (opens new window)。

# 9. 安全

默认情况下,数据流服务器是不安全的,并在未加密的 HTTP 连接上运行。你可以通过启用 HTTPS 并要求客户机使用OAuth 2.0 (opens new window)进行身份验证来保护 REST 端点以及数据流仪表板。

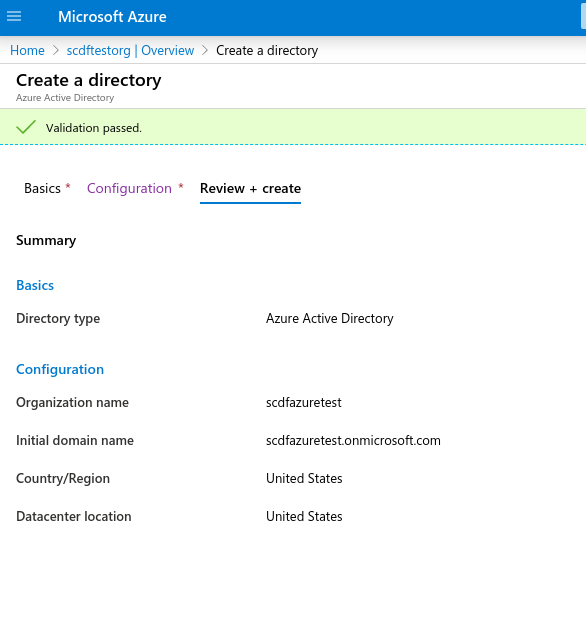

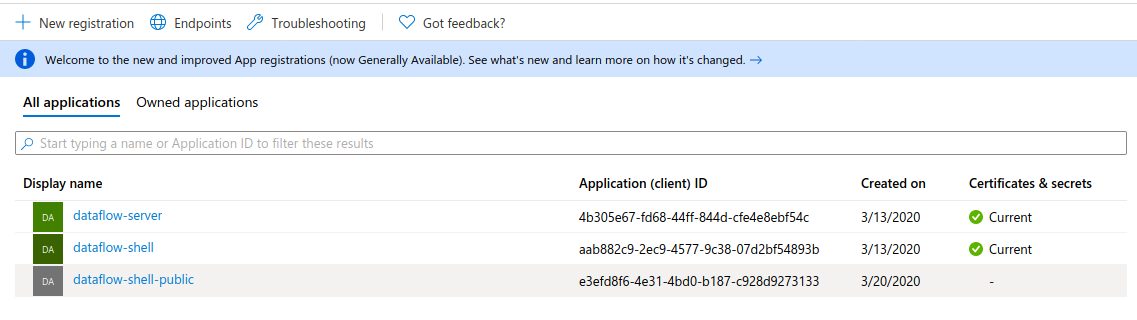

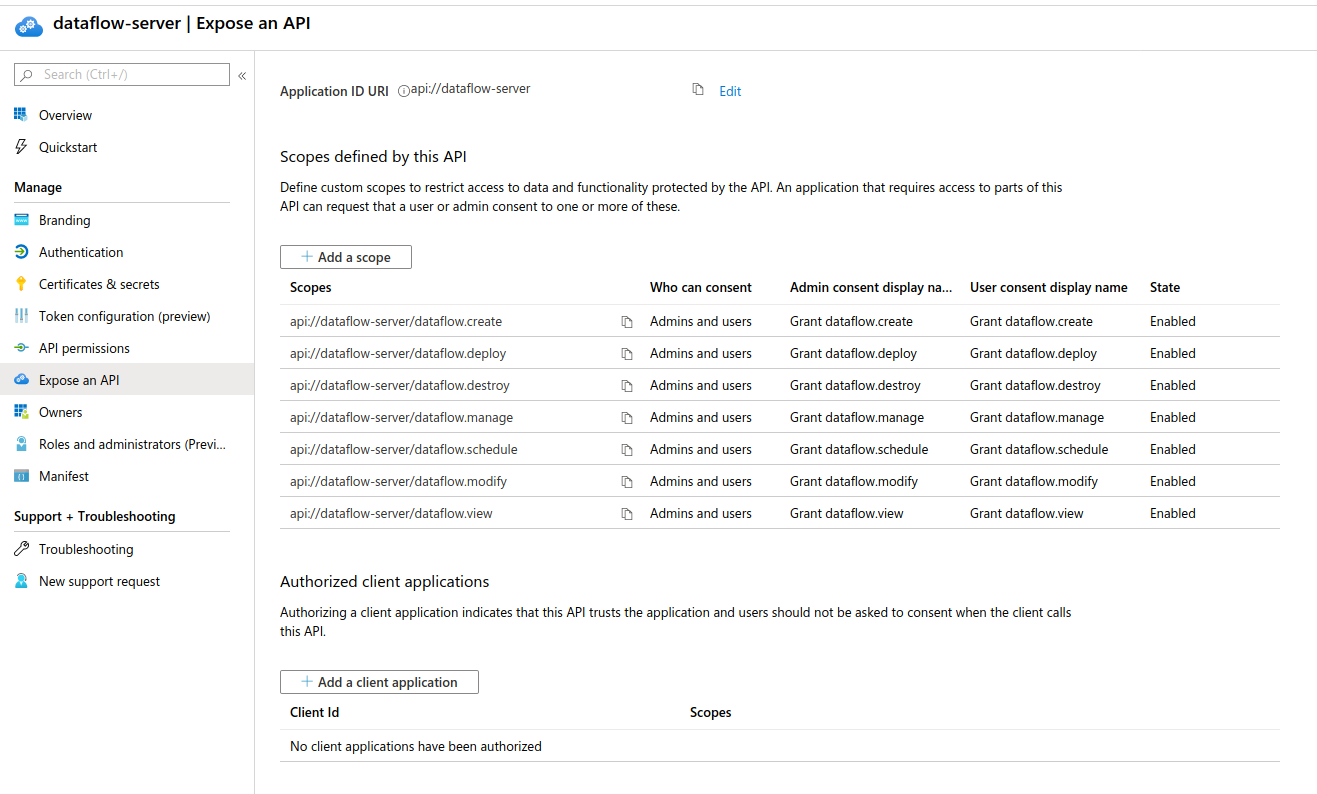

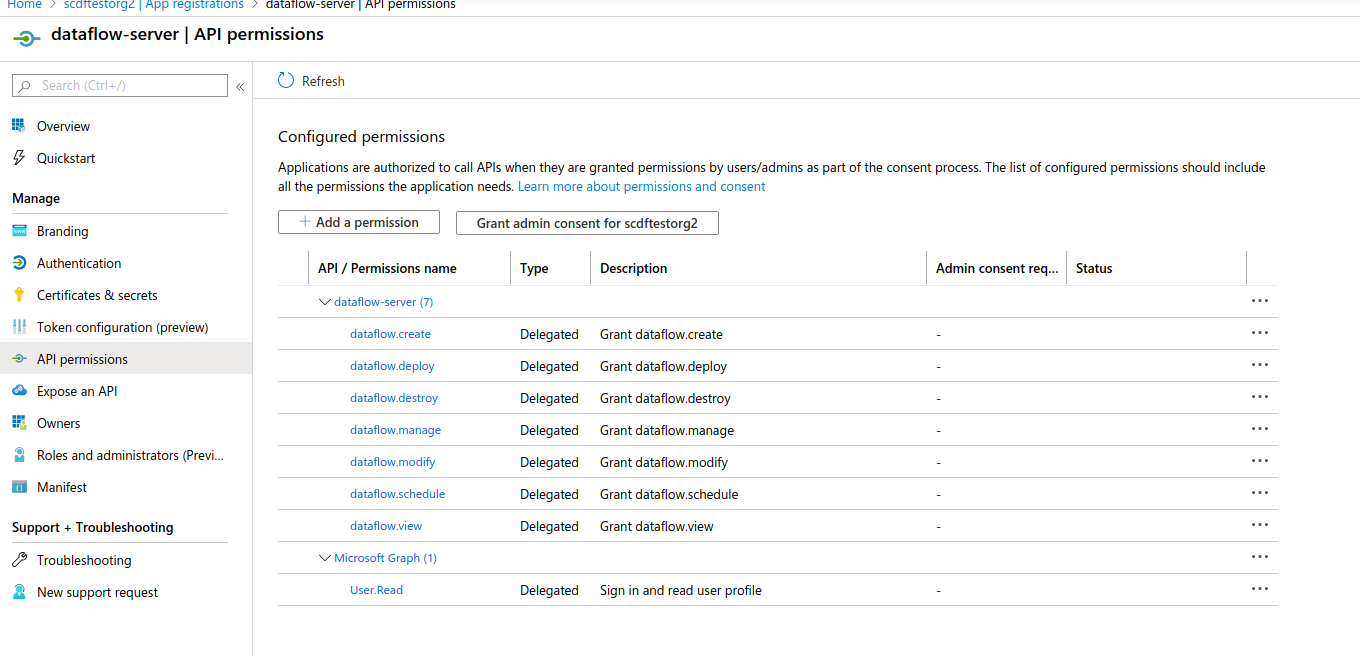

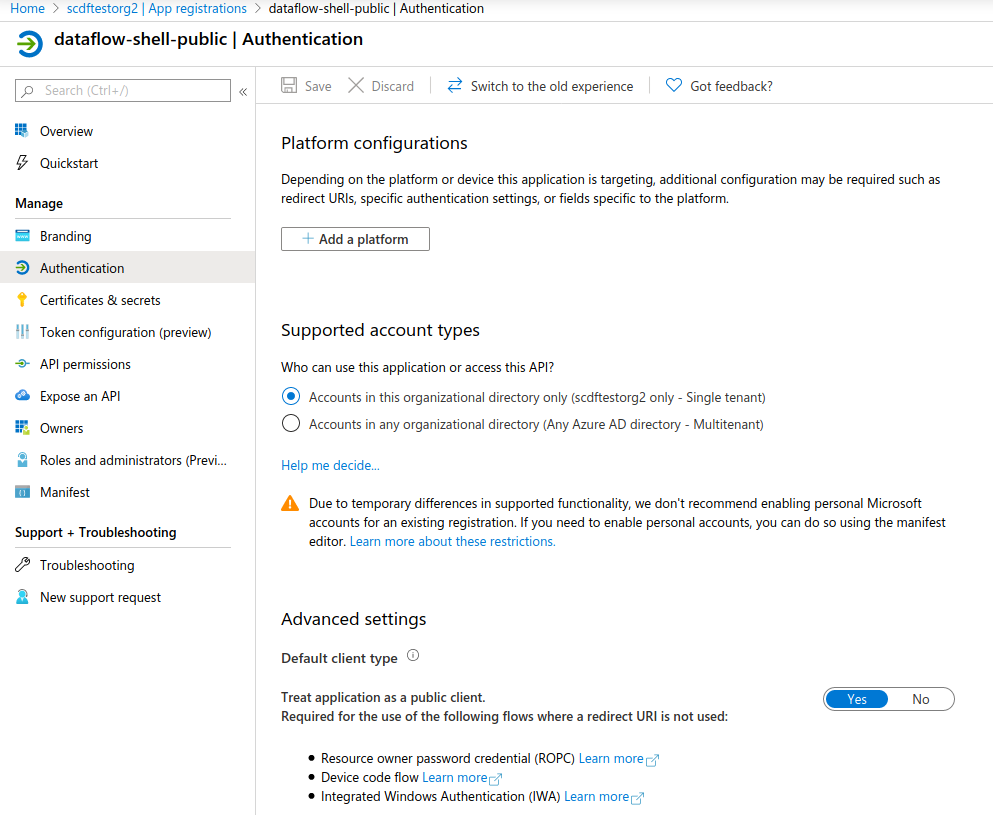

| 附录Azure包含如何 设置Azure 活动目录集成的更多信息。 |

|---|

| 默认情况下,REST 端点(管理、管理和健康状态)以及仪表板 UI 不需要经过身份验证的访问。 |

|---|

虽然理论上可以结合 Spring 云数据流选择任何 OAuth 提供商,但我们建议使用CloudFoundry 用户帐户和认证(UAA)服务器 (opens new window)。

UAAOpenID 不仅得到了认证,并由 Cloud Foundry 使用,而且你还可以在本地独立部署场景中使用它。此外,UAA 不仅提供了自己的用户存储,而且还提供了全面的 LDAP 集成。

# 9.1.启用 HTTPS

默认情况下,仪表板、管理和健康端点使用 HTTP 作为传输。你可以通过在application.yml中的配置中添加一个证书来切换到 HTTPS,如下例所示:

server:

port: 8443 (1)

ssl:

key-alias: yourKeyAlias (2)

key-store: path/to/keystore (3)

key-store-password: yourKeyStorePassword (4)

key-password: yourKeyPassword (5)

trust-store: path/to/trust-store (6)

trust-store-password: yourTrustStorePassword (7)

| 1 | 由于默认端口是9393,你可以选择将该端口更改为更常见的 HTTPS 典型端口。 |

|---|---|

| 2 | 密钥存储在密钥存储库中的别名(或名称)。 |

| 3 | 密钥存储文件的路径。你还可以通过使用 Classpath 前缀来指定 Classpath 资源-例如:classpath:path/to/keystore。 |

| 4 | 密钥存储库的密码。 |

| 5 | 密钥的密码。 |

| 6 | 信任存储文件的路径。你还可以通过使用 Classpath 前缀来指定 Classpath 资源-例如:classpath:path/to/trust-store |

| 7 | 信任存储的密码。 |

| 如果启用了 HTTPS,它将完全取代 HTTP 作为 上的协议,REST 端点和数据流仪表板将在该协议上进行交互。普通 HTTP 请求 失败。因此,请确保相应地配置你的 shell。 |

|---|

# 使用自签名证书

出于测试目的或在开发过程中,创建自签名证书可能比较方便。要开始,请执行以下命令来创建证书:

$ keytool -genkey -alias dataflow -keyalg RSA -keystore dataflow.keystore \

-validity 3650 -storetype JKS \

-dname "CN=localhost, OU=Spring, O=Pivotal, L=Kailua-Kona, ST=HI, C=US" (1)

-keypass dataflow -storepass dataflow

| 1 | CN是这里的重要参数。它应该匹配你试图访问的域-例如,localhost。 |

|---|

然后将以下行添加到你的application.yml文件中:

server:

port: 8443

ssl:

enabled: true

key-alias: dataflow

key-store: "/your/path/to/dataflow.keystore"

key-store-type: jks

key-store-password: dataflow

key-password: dataflow

这就是数据流服务器所需做的全部工作。一旦启动服务器,你应该能够在[localhost:8443/](https://localhost:8443/)上访问它。由于这是一个自签名的证书,你应该在浏览器中点击一个警告,你需要忽略它。

| 从来没有在生产中使用自签名证书。 |

|---|

# 自签名证书和 shell

默认情况下,自签名证书是 shell 的一个问题,需要额外的步骤才能使 shell 与自签名证书一起工作。有两种选择:

将自签名证书添加到 JVM 信任存储库中。

跳过证书验证。

# 将自签名证书添加到 JVM 信任存储库

为了使用 JVM 信任存储库选项,你需要从密钥存储库导出先前创建的证书,如下所示:

$ keytool -export -alias dataflow -keystore dataflow.keystore -file dataflow_cert -storepass dataflow

接下来,你需要创建一个 shell 可以使用的信任库,如下所示:

$ keytool -importcert -keystore dataflow.truststore -alias dataflow -storepass dataflow -file dataflow_cert -noprompt

现在,你已经准备好使用以下 JVM 参数启动数据流壳层了:

$ java -Djavax.net.ssl.trustStorePassword=dataflow \

-Djavax.net.ssl.trustStore=/path/to/dataflow.truststore \

-Djavax.net.ssl.trustStoreType=jks \

-jar spring-cloud-dataflow-shell-2.9.2.jar

| 如果在通过 SSL 建立连接时遇到麻烦,可以使用 日志,并将 javax.net.debugJVM 参数设置为ssl。 |

|---|

不要忘记使用以下命令锁定数据流服务器:

dataflow:> dataflow config server https://localhost:8443/

# 跳过证书验证

或者,你也可以通过提供可选的--dataflow.skip-ssl-validation=true命令行参数来绕过认证验证。

如果你设置了这个命令行参数,shell 将接受任何(自签名的)SSL 证书。

| 如果可能的话,你应该避免使用这个选项。禁用信任管理器 会破坏 SSL 的目的,并使你的应用程序容易受到中间人攻击。 |

|---|

# 9.2.使用 OAuth2.0 进行身份验证

为了支持身份验证和授权, Spring 云数据流使用OAuth 2.0 (opens new window)。它允许你将 Spring 云数据流集成到单点登录(SSO)环境中。

| Spring 在云数据流 2.0 中,OAuth2 是用于提供身份验证和授权的唯一机制 。 |

|---|

使用了以下 OAuth2 授予类型:

授权代码:用于 GUI(浏览器)集成。访问者将被重定向到你的 OAuth 服务进行身份验证。

密码:由 shell(和 REST 集成)使用,因此访问者可以使用用户名和密码登录

客户凭据:直接从 OAuth 提供程序检索访问令牌,并使用授权 HTTP 头将其传递给数据流服务器

| 当前, Spring 云数据流使用不透明的令牌和不透明的 令牌。 |

|---|

你可以通过两种方式访问 REST 端点:

基本身份验证,它使用密码授予类型对你的 OAuth2 服务进行身份验证

访问令牌,它使用客户端凭据授予类型

| 当你设置身份验证时,你确实应该启用 HTTPS,尤其是在生产环境中。 |

|---|

你可以通过向application.yml添加以下内容或通过设置环境变量来打开 OAuth2 身份验证。下面的示例显示了CloudFoundry 用户帐户和认证(UAA)服务器 (opens new window)所需的最小设置:

spring:

security:

oauth2: (1)

client:

registration:

uaa: (2)

client-id: myclient

client-secret: mysecret

redirect-uri: '{baseUrl}/login/oauth2/code/{registrationId}'

authorization-grant-type: authorization_code

scope:

- openid (3)

provider:

uaa:

jwk-set-uri: http://uaa.local:8080/uaa/token_keys

token-uri: http://uaa.local:8080/uaa/oauth/token

user-info-uri: http://uaa.local:8080/uaa/userinfo (4)

user-name-attribute: user_name (5)

authorization-uri: http://uaa.local:8080/uaa/oauth/authorize

resourceserver:

opaquetoken:

introspection-uri: http://uaa.local:8080/uaa/introspect (6)

client-id: dataflow

client-secret: dataflow

| 1 | 提供此属性将激活 OAuth2 安全性。 |

|---|---|

| 2 | 提供者 ID。你可以指定多个提供者。 |

| 3 | 由于 UAA 是 OpenID 提供程序,因此你必须至少指定openid范围。如果你的提供程序还提供了其他范围来控制角色分配, 你还必须在此指定这些范围。 |

| 4 | OpenID 端点。用于检索用户信息,如用户名。强制性的。 |

| 5 | 包含用户名的响应的 JSON 属性。 |

| 6 | 用于内省和验证一个直接传入的令牌。强制性的。 |

你可以使用 curl 验证基本身份验证是否正常工作,如下所示:

curl -u myusername:mypassword http://localhost:9393/ -H 'Accept: application/json'

因此,你应该看到一个可用的 REST 端点列表。

| 当你使用 Web 浏览器访问根 URL 并启用 安全性时,你将被重定向到仪表板 UI。要查看休息端点的 列表,请指定 application/json``Accept标头。也要确保通过使用Postman (opens new window)(Chrome) 或RESTClient (opens new window)(Firefox)等工具添加 Accept头。 |

|---|

除了基本的身份验证,你还可以提供一个访问令牌,以访问 REST API。为此,从你的 OAuth2 提供程序检索一个 OAuth2 访问令牌,并使用授权HTTP 报头将该访问令牌传递给 REST API,如下所示:

$ curl -H "Authorization: Bearer <ACCESS_TOKEN>" http://localhost:9393/ -H 'Accept: application/json'

# 9.3.自定义授权

前面的内容主要涉及身份验证——即如何评估用户的身份。在本节中,我们将讨论可用的 ** 授权 ** 选项—即谁可以做什么。

该授权规则在dataflow-server-defaults.yml( Spring 云数据流核心模块的一部分)中定义。

由于安全角色的确定是特定于环境的, Spring 云数据流在默认情况下将所有角色分配给经过身份验证的 OAuth2 用户。DefaultDataflowAuthoritiesExtractor类用于此目的。

或者,通过将你的提供者的布尔属性map-oauth-scopes设置为true(默认值为false),可以将 Spring 云数据流映射到数据流角色。例如,如果你的提供者的 ID 是uaa,则属性将是spring.cloud.dataflow.security.authorization.provider-role-mappings.uaa.map-oauth-scopes。

有关更多详细信息,请参见角色映射一章。

你还可以通过提供你自己的 Spring Bean 定义来定制角色映射行为,该定义扩展了 Spring 云数据流的AuthorityMapper接口。在这种情况下,自定义 Bean 的定义优先于 Spring 云数据流提供的默认定义。

默认方案使用七个角色来保护 Spring 云数据流公开的REST 端点:

角色 _ 创建:用于任何涉及创建的内容,例如创建流或任务

角色 _ 部署:用于部署流或启动任务

角色 _destroy:用于任何涉及删除流、任务等的内容。

角色 _ 管理:用于引导管理端点

角色 _ 修改:对于任何涉及系统状态突变的内容

角色 _ 日程安排:用于调度相关操作(例如调度任务)

角色 _ 视图:对于任何与检索状态有关的内容

正如本节前面提到的,所有与授权相关的默认设置都在dataflow-server-defaults.yml中指定,这是 Spring 云数据流核心模块的一部分。尽管如此,如果需要,你可以重写这些设置——例如,在application.yml中。该配置采用 YAML 列表的形式(因为某些规则可能优先于其他规则)。因此,你需要复制和粘贴整个列表,并根据你的需要对其进行定制(因为无法合并列表)。

始终引用application.yml文件的版本,因为下面的代码片段可能已经过时了。 |

|---|

默认规则如下:

spring:

cloud:

dataflow:

security:

authorization:

enabled: true

loginUrl: "/"

permit-all-paths: "/authenticate,/security/info,/assets/**,/dashboard/logout-success-oauth.html,/favicon.ico"

rules:

# About

- GET /about => hasRole('ROLE_VIEW')

# Audit

- GET /audit-records => hasRole('ROLE_VIEW')

- GET /audit-records/** => hasRole('ROLE_VIEW')

# Boot Endpoints

- GET /management/** => hasRole('ROLE_MANAGE')

# Apps

- GET /apps => hasRole('ROLE_VIEW')

- GET /apps/** => hasRole('ROLE_VIEW')

- DELETE /apps/** => hasRole('ROLE_DESTROY')

- POST /apps => hasRole('ROLE_CREATE')

- POST /apps/** => hasRole('ROLE_CREATE')

- PUT /apps/** => hasRole('ROLE_MODIFY')

# Completions

- GET /completions/** => hasRole('ROLE_VIEW')

# Job Executions & Batch Job Execution Steps && Job Step Execution Progress

- GET /jobs/executions => hasRole('ROLE_VIEW')

- PUT /jobs/executions/** => hasRole('ROLE_MODIFY')

- GET /jobs/executions/** => hasRole('ROLE_VIEW')

- GET /jobs/thinexecutions => hasRole('ROLE_VIEW')

# Batch Job Instances

- GET /jobs/instances => hasRole('ROLE_VIEW')

- GET /jobs/instances/* => hasRole('ROLE_VIEW')

# Running Applications

- GET /runtime/streams => hasRole('ROLE_VIEW')

- GET /runtime/streams/** => hasRole('ROLE_VIEW')

- GET /runtime/apps => hasRole('ROLE_VIEW')

- GET /runtime/apps/** => hasRole('ROLE_VIEW')

# Stream Definitions

- GET /streams/definitions => hasRole('ROLE_VIEW')

- GET /streams/definitions/* => hasRole('ROLE_VIEW')

- GET /streams/definitions/*/related => hasRole('ROLE_VIEW')

- POST /streams/definitions => hasRole('ROLE_CREATE')

- DELETE /streams/definitions/* => hasRole('ROLE_DESTROY')

- DELETE /streams/definitions => hasRole('ROLE_DESTROY')

# Stream Deployments

- DELETE /streams/deployments/* => hasRole('ROLE_DEPLOY')

- DELETE /streams/deployments => hasRole('ROLE_DEPLOY')

- POST /streams/deployments/** => hasRole('ROLE_MODIFY')

- GET /streams/deployments/** => hasRole('ROLE_VIEW')

# Stream Validations

- GET /streams/validation/ => hasRole('ROLE_VIEW')

- GET /streams/validation/* => hasRole('ROLE_VIEW')

# Stream Logs

- GET /streams/logs/* => hasRole('ROLE_VIEW')

# Task Definitions

- POST /tasks/definitions => hasRole('ROLE_CREATE')

- DELETE /tasks/definitions/* => hasRole('ROLE_DESTROY')

- GET /tasks/definitions => hasRole('ROLE_VIEW')

- GET /tasks/definitions/* => hasRole('ROLE_VIEW')

# Task Executions

- GET /tasks/executions => hasRole('ROLE_VIEW')

- GET /tasks/executions/* => hasRole('ROLE_VIEW')

- POST /tasks/executions => hasRole('ROLE_DEPLOY')

- POST /tasks/executions/* => hasRole('ROLE_DEPLOY')

- DELETE /tasks/executions/* => hasRole('ROLE_DESTROY')

# Task Schedules

- GET /tasks/schedules => hasRole('ROLE_VIEW')

- GET /tasks/schedules/* => hasRole('ROLE_VIEW')

- GET /tasks/schedules/instances => hasRole('ROLE_VIEW')

- GET /tasks/schedules/instances/* => hasRole('ROLE_VIEW')

- POST /tasks/schedules => hasRole('ROLE_SCHEDULE')

- DELETE /tasks/schedules/* => hasRole('ROLE_SCHEDULE')

# Task Platform Account List */

- GET /tasks/platforms => hasRole('ROLE_VIEW')

# Task Validations

- GET /tasks/validation/ => hasRole('ROLE_VIEW')

- GET /tasks/validation/* => hasRole('ROLE_VIEW')

# Task Logs

- GET /tasks/logs/* => hasRole('ROLE_VIEW')

# Tools

- POST /tools/** => hasRole('ROLE_VIEW')

每一行的格式如下:

HTTP_METHOD URL_PATTERN '=>' SECURITY_ATTRIBUTE

地点:

HTTP_Method 是一种 HTTP 方法(如 PUT 或 GET),大写的情况。

URL_Pattern 是一种 Ant 风格的 URL 模式。

Security_Attribute 是一个 SPEL 表达式。见基于表达式的访问控制 (opens new window)。

每个字符都用一个或空白字符(空格、制表符等)隔开。

请注意,上面是一个 YAML 列表,而不是一个位于spring.cloud.dataflow.security.authorization.rules键下的映射(因此在每一行的开始处使用’-’破折号)。

# 授权——shell 和 dashboard 行为

当启用安全性时,仪表板和外壳是角色感知的,这意味着,根据分配的角色,并非所有功能都是可见的。

例如,用户没有必要角色的 shell 命令被标记为不可用。

目前,shell 的help命令列出了不可用的命令。请跟踪以下问题:github.com/spring-projects/spring-shell/issues/115 (opens new window) |

|---|

相反,对于仪表板,UI 不会显示用户未获得授权的页面或页面元素。

# 保护 Spring 引导管理端点

启用安全性时,Spring Boot HTTP Management Endpoints (opens new window)将以与其他 REST 端点相同的方式进行安全性保护。管理 REST 端点在/management下可用,并且需要MANAGEMENT角色。

dataflow-server-defaults.yml中的默认配置如下:

management:

endpoints:

web:

base-path: /management

security:

roles: MANAGE

| 目前,你不应该自定义默认的管理路径。 |

|---|

# 9.4.建立 UAA 身份验证

对于本地部署场景,我们建议使用CloudFoundry 用户帐户和认证(UAA)服务器 (opens new window),即OpenID 认证 (opens new window)。虽然 UAA 由Cloud Foundry (opens new window)使用,但它也是一个功能齐全的独立 OAuth2 服务器,具有 Enterprise 功能,例如LDAP 集成 (opens new window)。

# 所需经费

你需要签出、构建和运行 UAA。要做到这一点,请确保:

使用 Java8.

在同一台计算机上运行时,对 UAA 使用不同的主机名——例如,

[uaa/](http://uaa/)。

如果在安装UAAC时遇到问题,则可能需要设置GEM_HOME环境变量:

export GEM_HOME="$HOME/.gem"

你还应该确保~/.gem/gems/cf-uaac-4.2.0/bin已被添加到你的路径中。

# 为 JWT 编写 UAA

由于 UAA 是一个 OpenID 提供者,并且使用 JSON Web 令牌,因此它需要一个私钥来对这些 JWTS 进行签名:

openssl genrsa -out signingkey.pem 2048

openssl rsa -in signingkey.pem -pubout -out verificationkey.pem

export JWT_TOKEN_SIGNING_KEY=$(cat signingkey.pem)

export JWT_TOKEN_VERIFICATION_KEY=$(cat verificationkey.pem)

稍后,一旦 UAA 被启动,你就可以在访问[uaa:8080/uaa/token_keys](http://uaa:8080/uaa/token_keys)时看到这些键。

在这里,URL[uaa:8080/uaa/token_keys](http://uaa:8080/uaa/token_keys)中的uaa是主机名。 |

|---|

# 下载并启动 UAA

要下载和安装 UAA,请运行以下命令:

git clone https://github.com/pivotal/uaa-bundled.git

cd uaa-bundled

./mvnw clean install

java -jar target/uaa-bundled-1.0.0.BUILD-SNAPSHOT.jar

UAA 的配置由 YAML 文件uaa.yml驱动,或者你可以使用 UAA 命令行客户端编写配置脚本:

uaac target http://uaa:8080/uaa

uaac token client get admin -s adminsecret

uaac client add dataflow \

--name dataflow \

--secret dataflow \

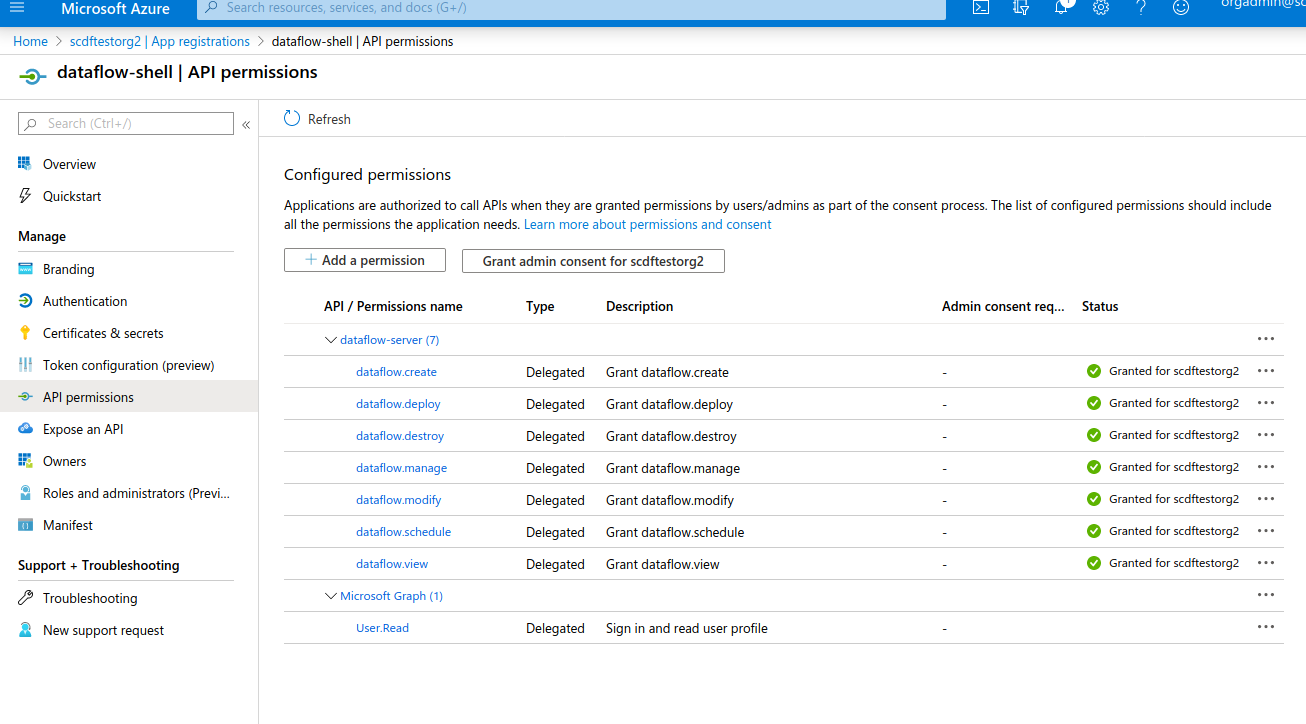

--scope cloud_controller.read,cloud_controller.write,openid,password.write,scim.userids,sample.create,sample.view,dataflow.create,dataflow.deploy,dataflow.destroy,dataflow.manage,dataflow.modify,dataflow.schedule,dataflow.view \

--authorized_grant_types password,authorization_code,client_credentials,refresh_token \

--authorities uaa.resource,dataflow.create,dataflow.deploy,dataflow.destroy,dataflow.manage,dataflow.modify,dataflow.schedule,dataflow.view,sample.view,sample.create\

--redirect_uri http://localhost:9393/login \

--autoapprove openid

uaac group add "sample.view"

uaac group add "sample.create"

uaac group add "dataflow.view"

uaac group add "dataflow.create"

uaac user add springrocks -p mysecret --emails [email protected]

uaac user add vieweronly -p mysecret --emails [email protected]

uaac member add "sample.view" springrocks

uaac member add "sample.create" springrocks

uaac member add "dataflow.view" springrocks

uaac member add "dataflow.create" springrocks

uaac member add "sample.view" vieweronly

前面的脚本设置了 DataFlow 客户机和两个用户:

用户洒水车同时具有两个作用域:

sample.view和sample.create。用户仅限 Vieweronly只有一个作用域:

sample.view。

添加后,你可以快速重复检查 UAA 是否已创建用户:

curl -v -d"username=springrocks&password=mysecret&client_id=dataflow&grant_type=password" -u "dataflow:dataflow" http://uaa:8080/uaa/oauth/token -d 'token_format=opaque'

前面的命令应该产生类似于下面的输出:

* Trying 127.0.0.1...

* TCP_NODELAY set

* Connected to uaa (127.0.0.1) port 8080 (#0)

* Server auth using Basic with user 'dataflow'

> POST /uaa/oauth/token HTTP/1.1

> Host: uaa:8080

> Authorization: Basic ZGF0YWZsb3c6ZGF0YWZsb3c=

> User-Agent: curl/7.54.0

> Accept: */*

> Content-Length: 97

> Content-Type: application/x-www-form-urlencoded

>

* upload completely sent off: 97 out of 97 bytes

< HTTP/1.1 200

< Cache-Control: no-store

< Pragma: no-cache

< X-XSS-Protection: 1; mode=block

< X-Frame-Options: DENY

< X-Content-Type-Options: nosniff

< Content-Type: application/json;charset=UTF-8

< Transfer-Encoding: chunked

< Date: Thu, 31 Oct 2019 21:22:59 GMT

<

* Connection #0 to host uaa left intact

{"access_token":"0329c8ecdf594ee78c271e022138be9d","token_type":"bearer","id_token":"eyJhbGciOiJSUzI1NiIsImprdSI6Imh0dHBzOi8vbG9jYWxob3N0OjgwODAvdWFhL3Rva2VuX2tleXMiLCJraWQiOiJsZWdhY3ktdG9rZW4ta2V5IiwidHlwIjoiSldUIn0.eyJzdWIiOiJlZTg4MDg4Ny00MWM2LTRkMWQtYjcyZC1hOTQ4MmFmNGViYTQiLCJhdWQiOlsiZGF0YWZsb3ciXSwiaXNzIjoiaHR0cDovL2xvY2FsaG9zdDo4MDkwL3VhYS9vYXV0aC90b2tlbiIsImV4cCI6MTU3MjYwMDE3OSwiaWF0IjoxNTcyNTU2OTc5LCJhbXIiOlsicHdkIl0sImF6cCI6ImRhdGFmbG93Iiwic2NvcGUiOlsib3BlbmlkIl0sImVtYWlsIjoic3ByaW5ncm9ja3NAc29tZXBsYWNlLmNvbSIsInppZCI6InVhYSIsIm9yaWdpbiI6InVhYSIsImp0aSI6IjAzMjljOGVjZGY1OTRlZTc4YzI3MWUwMjIxMzhiZTlkIiwiZW1haWxfdmVyaWZpZWQiOnRydWUsImNsaWVudF9pZCI6ImRhdGFmbG93IiwiY2lkIjoiZGF0YWZsb3ciLCJncmFudF90eXBlIjoicGFzc3dvcmQiLCJ1c2VyX25hbWUiOiJzcHJpbmdyb2NrcyIsInJldl9zaWciOiJlOTkyMDQxNSIsInVzZXJfaWQiOiJlZTg4MDg4Ny00MWM2LTRkMWQtYjcyZC1hOTQ4MmFmNGViYTQiLCJhdXRoX3RpbWUiOjE1NzI1NTY5Nzl9.bqYvicyCPB5cIIu_2HEe5_c7nSGXKw7B8-reTvyYjOQ2qXSMq7gzS4LCCQ-CMcb4IirlDaFlQtZJSDE-_UsM33-ThmtFdx--TujvTR1u2nzot4Pq5A_ThmhhcCB21x6-RNNAJl9X9uUcT3gKfKVs3gjE0tm2K1vZfOkiGhjseIbwht2vBx0MnHteJpVW6U0pyCWG_tpBjrNBSj9yLoQZcqrtxYrWvPHaa9ljxfvaIsOnCZBGT7I552O1VRHWMj1lwNmRNZy5koJFPF7SbhiTM8eLkZVNdR3GEiofpzLCfoQXrr52YbiqjkYT94t3wz5C6u1JtBtgc2vq60HmR45bvg","refresh_token":"6ee95d017ada408697f2d19b04f7aa6c-r","expires_in":43199,"scope":"scim.userids openid sample.create cloud_controller.read password.write cloud_controller.write sample.view","jti":"0329c8ecdf594ee78c271e022138be9d"}

通过使用token_format参数,你可以请求令牌为:

不透明

JWT

# 10. 配置-本地

# 10.1.功能切换

Spring 云数据流服务器提供了一组特定的特性,这些特性可以在启动时启用/禁用。这些特性包括用于以下方面的所有生命周期操作和 REST 端点(服务器和客户端实现,包括 shell 和 UI):

Streams(需要 Skipper)

任务

任务调度程序

在启动数据流服务器时,可以通过设置以下布尔属性来启用和禁用这些功能:

spring.cloud.dataflow.features.streams-enabledspring.cloud.dataflow.features.tasks-enabledspring.cloud.dataflow.features.schedules-enabled

默认情况下,Stream(需要 Skipper)和 Tasks 是启用的,而 Task Scheduler 是默认情况下禁用的。

REST/about端点提供关于已启用和禁用的特性的信息。

# 10.2.数据库

关系数据库用于存储流和任务定义以及执行任务的状态。 Spring 云数据流为H2、MySQL、甲骨文、PostgreSQL、DB2和SQL 服务器提供模式。当服务器启动时,架构会自动创建。

默认情况下, Spring 云数据流提供了H2数据库的嵌入式实例。H2数据库适合用于开发目的,但不建议用于生产用途。

| H2数据库不支持作为外部模式。 |

|---|

MySQL(通过 MariaDB 驱动程序)、PostgreSQL、SQL 服务器和嵌入式H2的 JDBC 驱动程序是可用的,无需额外配置。如果你正在使用任何其他数据库,那么你需要在服务器的 Classpath 上放置相应的 JDBC 驱动程序 JAR。

数据库属性可以作为环境变量或命令行参数传递给数据流服务器。

# 10.2.1.MySQL

下面的示例展示了如何使用 MariaDB 驱动程序定义 MySQL 数据库连接。

java -jar spring-cloud-dataflow-server/target/spring-cloud-dataflow-server-2.9.2.jar \

--spring.datasource.url=jdbc:mysql://localhost:3306/mydb \

--spring.datasource.username= \

--spring.datasource.password= \

--spring.datasource.driver-class-name=org.mariadb.jdbc.Driver

最高5.7的 MySQL 版本可以与 MariaDB 驱动程序一起使用。从版本8.0开始,必须使用 MySQL 自己的驱动程序。

java -jar spring-cloud-dataflow-server/target/spring-cloud-dataflow-server-2.9.2.jar \

--spring.datasource.url=jdbc:mysql://localhost:3306/mydb \

--spring.datasource.username= \

--spring.datasource.password= \

--spring.datasource.driver-class-name=com.mysql.jdbc.Driver

| 由于许可证限制,我们无法捆绑 MySQL 驱动程序。你需要自己将其添加到 服务器的 Classpath 中。 |

|---|

# 10.2.2.马里亚布

下面的示例展示了如何使用命令行参数定义 MariaDB 数据库连接。

java -jar spring-cloud-dataflow-server/target/spring-cloud-dataflow-server-2.9.2.jar \

--spring.datasource.url=jdbc:mariadb://localhost:3306/mydb?useMysqlMetadata=true \

--spring.datasource.username= \

--spring.datasource.password= \

--spring.datasource.driver-class-name=org.mariadb.jdbc.Driver

从 MariaDB V2.4.1Connector 发行版开始,还需要向 JDBC URL 添加useMysqlMetadata=true。在 MySQL 和 MariaDB 完全转换为两个不同的数据库之前,这是一个必需的解决方案。

MariaDB 版本10.3引入了对真实数据库序列的支持,这是又一个突破性的变化,而这些数据库周围的工具完全支持 MySQL 和 MariaDB 作为单独的数据库类型。解决办法是使用较老的方言,而不是尝试使用序列。

java -jar spring-cloud-dataflow-server/target/spring-cloud-dataflow-server-2.9.2.jar \

--spring.datasource.url=jdbc:mariadb://localhost:3306/mydb?useMysqlMetadata=true \

--spring.datasource.username= \

--spring.datasource.password= \

--spring.jpa.properties.hibernate.dialect=org.hibernate.dialect.MariaDB102Dialect \

--spring.datasource.driver-class-name=org.mariadb.jdbc.Driver

# 10.2.3.PostgreSQL

下面的示例展示了如何使用命令行参数定义 PostgreSQL 数据库连接:

java -jar spring-cloud-dataflow-server/target/spring-cloud-dataflow-server-2.9.2.jar \

--spring.datasource.url=jdbc:postgresql://localhost:5432/mydb \

--spring.datasource.username= \

--spring.datasource.password= \

--spring.datasource.driver-class-name=org.postgresql.Driver

# 10.2.4.SQL 服务器

下面的示例展示了如何使用命令行参数定义 SQL Server 数据库连接:

java -jar spring-cloud-dataflow-server/target/spring-cloud-dataflow-server-2.9.2.jar \

--spring.datasource.url='jdbc:sqlserver://localhost:1433;databaseName=mydb' \

--spring.datasource.username= \

--spring.datasource.password= \

--spring.datasource.driver-class-name=com.microsoft.sqlserver.jdbc.SQLServerDriver

# 10.2.5.DB2

下面的示例展示了如何使用命令行参数定义 DB2 数据库连接:

java -jar spring-cloud-dataflow-server/target/spring-cloud-dataflow-server-2.9.2.jar \

--spring.datasource.url=jdbc:db2://localhost:50000/mydb \

--spring.datasource.username= \

--spring.datasource.password= \

--spring.datasource.driver-class-name=com.ibm.db2.jcc.DB2Driver

| 由于许可限制,我们无法捆绑 DB2Driver。你需要自己将其添加到 服务器的 Classpath 中。 |

|---|

# 10.2.6.甲骨文

下面的示例展示了如何使用命令行参数定义 Oracle 数据库连接:

java -jar spring-cloud-dataflow-server/target/spring-cloud-dataflow-server-2.9.2.jar \

--spring.datasource.url=jdbc:oracle:thin:@localhost:1521/MYDB \

--spring.datasource.username= \

--spring.datasource.password= \

--spring.datasource.driver-class-name=oracle.jdbc.OracleDriver

| 由于许可证限制,我们无法捆绑 Oracle Driver。你需要自己将其添加到 服务器的 Classpath 中。 |

|---|

# 10.2.7.添加自定义 JDBC 驱动程序

要为数据库添加自定义驱动程序(例如,Oracle),你应该重建数据流服务器,并将依赖项添加到 Maven pom.xml文件中。你需要修改spring-cloud-dataflow-server模块的 Maven pom.xml。GitHub 存储库中有 GA 发布标记,因此你可以切换到所需的 GA 标记,以便在生产就绪代码库中添加驱动程序。

要为 Spring 云数据流服务器添加自定义的 JDBC 驱动程序依赖项:

选择与要重建和克隆 GitHub 存储库的服务器版本对应的标记。

编辑 Spring-cloud-dataflow-server/ POM.xml,并在

dependencies部分中添加所需的数据库驱动程序的依赖项。在下面的示例中,选择了一个 Oracle 驱动程序:

<dependencies>

...

<dependency>

<groupId>com.oracle.jdbc</groupId>

<artifactId>ojdbc8</artifactId>

<version>12.2.0.1</version>

</dependency>

...

</dependencies>

- 按照Building Spring Cloud Data Flow中所述构建应用程序

还可以通过向 dataFlow-server.yml 文件添加必要的属性,在重建服务器时提供默认值,如下面的 PostgreSQL 示例所示:

spring:

datasource:

url: jdbc:postgresql://localhost:5432/mydb

username: myuser

password: mypass

driver-class-name:org.postgresql.Driver

- 或者,你可以使用你的构建文件构建自定义的云数据流服务器 Spring。如果需要添加驱动程序 JAR,则在回购样本 (opens new window)中有自定义服务器构建的示例。

# 10.2.8.模式处理

在默认情况下,数据库模式是用飞道管理的,如果可以给数据库用户足够的权限,这是很方便的。

下面是对船长服务器启动时发生的情况的描述:

Flyway 检查

flyway_schema_history表是否存在。如果架构不是空的,那么基线(到版本 1)是否存在,因为如果使用共享 DB,数据流表可能就在适当的位置。

如果模式为空,Flyway 假定从头开始。

完成所有需要的模式迁移。

下面是对数据流服务器启动时发生的情况的描述:

Flyway 检查

flyway_schema_history_dataflow表是否存在。如果架构不是空的,那么基线(到版本 1)是否存在,因为如果使用共享 DB,船长表可能就在适当的位置。

如果模式为空,Flyway 假定从头开始。

完成所有需要的模式迁移。

由于历史原因,如果我们检测到模式来自1.7.x行,我们将这些转换为2.0.x起所需的结构,并完全继续使用 Flyway。

我们的源代码schemas (opens new window)中有模式 DDL,如果飞道通过使用配置spring.flyway.enabled=false禁用,则可以手动使用它。如果公司的数据库受到限制,即应用程序本身无法创建模式,那么这是一个很好的选择。 |

|---|

# 10.3.部署人员属性

你可以使用本地部署人员 (opens new window)的以下配置属性来自定义如何部署流和任务。当使用数据流 shell 进行部署时,可以使用语法deployer.<appName>.local.<deployerPropertyName>。参见下面的 shell 用法示例。这些属性还用于在数据流服务器和 Skipper 中的本地平台中配置本地任务平台以部署流时使用。

| Deployer Property Name | Description | 默认值 |

|---|---|---|

| workingDirectoriesRoot | Directory in which all created processes will run and create log files. | java.io.tmpdir |

| envVarsToInherit | Array of regular expression patterns for environment variables that are passed to launched applications. | Windows 上的 <"TMP", "LANG", "LANGUAGE", "LC_.*", "PATH", "SPRING_APPLICATION_JSON">和 UNIX 上的 <"TMP", "LANG", "LANGUAGE", "LC_.*", "PATH"> |

| deleteFilesOnExit | Whether to delete created files and directories on JVM exit. | true |

| javaCmd | Command to run java | 爪哇 |

| shutdownTimeout | Max number of seconds to wait for app shutdown. | 30 |

| javaOpts | The Java Options to pass to the JVM, e.g -Dtest=foo | <none> |

| inheritLogging | allow logging to be redirected to the output stream of the process that triggered child process. | false |

| debugPort | Port for remote debugging | <none> |

例如,要在ticktock流中为 Time 应用程序设置 Java 选项,请使用以下流部署属性。

dataflow:> stream create --name ticktock --definition "time --server.port=9000 | log"

dataflow:> stream deploy --name ticktock --properties "deployer.time.local.javaOpts=-Xmx2048m -Dtest=foo"

为了方便起见,你可以设置deployer.memory属性来设置 Java 选项-Xmx,如下例所示:

dataflow:> stream deploy --name ticktock --properties "deployer.time.memory=2048m"

在部署时,如果在deployer.<app>.local.javaOpts属性中指定一个-Xmx选项以及deployer.<app>.local.memory选项的值,则javaOpts属性中的值具有优先权。此外,部署应用程序时的javaOpts属性集具有优于数据流服务器的spring.cloud.deployer.local.javaOpts属性的优先权。

# 10.4.伐木

Spring 云数据流local服务器被自动配置为使用RollingFileAppender进行日志记录。日志配置位于名为logback-spring.xml的文件中包含的 Classpath 上。

默认情况下,日志文件被配置为使用:

<property name="LOG_FILE" value="${LOG_FILE:-${LOG_PATH:-${LOG_TEMP:-${java.io.tmpdir:-/tmp}}}/spring-cloud-dataflow-server}"/>

使用RollingPolicy的注销配置:

<appender name="FILE"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${LOG_FILE}.log</file>

<rollingPolicy

class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<!-- daily rolling -->

<fileNamePattern>${LOG_FILE}.${LOG_FILE_ROLLING_FILE_NAME_PATTERN:-%d{yyyy-MM-dd}}.%i.gz</fileNamePattern>

<maxFileSize>${LOG_FILE_MAX_SIZE:-100MB}</maxFileSize>

<maxHistory>${LOG_FILE_MAX_HISTORY:-30}</maxHistory>

<totalSizeCap>${LOG_FILE_TOTAL_SIZE_CAP:-500MB}</totalSizeCap>

</rollingPolicy>

<encoder>

<pattern>${FILE_LOG_PATTERN}</pattern>

</encoder>

</appender>

要检查当前 Spring 云数据流服务器java.io.tmpdir服务器的local服务器,

jinfo <pid> | grep "java.io.tmpdir"

如果要更改或重写任何属性LOG_FILE、LOG_TEMP、LOG_TEMP、LOG_FILE_MAX_SIZE、LOG_FILE_MAX_HISTORY和LOG_FILE_TOTAL_SIZE_CAP,请将它们设置为系统属性。

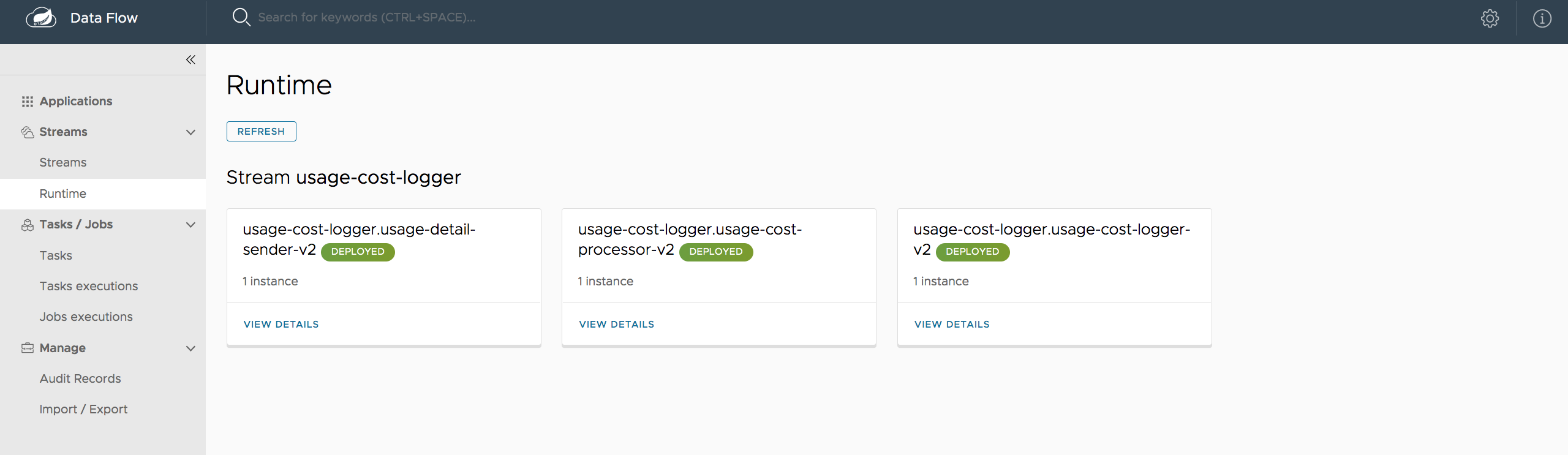

# 10.5.溪流

数据流服务器将流的生命周期的管理委托给 Skipper 服务器。将配置属性spring.cloud.skipper.client.serverUri设置为 Skipper 的位置,例如

$ java -jar spring-cloud-dataflow-server-2.9.2.jar --spring.cloud.skipper.client.serverUri=https://192.51.100.1:7577/api

Show Streams 的配置是通过在 Skipper 服务器上配置platform accounts来部署的,以及部署到哪些平台。有关更多信息,请参见platforms (opens new window)上的文档。

# 10.6.任务

数据流服务器负责部署任务。数据流启动的任务将其状态写入数据流服务器使用的同一数据库。对于 Spring 批处理作业的任务,作业和步骤执行数据也存储在该数据库中。与 Skipper 推出的流一样,任务可以在多个平台上启动。如果没有定义平台,则使用类LocalDeployerProperties (opens new window)的默认值创建一个名为default的平台,该值在表本地部署人员属性中进行了总结

要为本地平台配置新的平台帐户,请在你的application.yaml文件中的spring.cloud.dataflow.task.platform.local节下通过另一种 Spring 启动支持的机制提供一个条目。在下面的示例中,创建了两个名为localDev和localDevDebug的本地平台帐户。诸如shutdownTimeout和javaOpts之类的键是本地部署程序属性。

spring:

cloud:

dataflow:

task:

platform:

local:

accounts:

localDev:

shutdownTimeout: 60

javaOpts: "-Dtest=foo -Xmx1024m"

localDevDebug:

javaOpts: "-Xdebug -Xmx2048m"

通过将一个平台定义为default,你可以跳过使用platformName,否则将需要使用该平台。 |

|---|

启动任务时,使用 Task Launch 选项--platformName传递平台帐户名的值platformName如果不传递platformName的值,则将使用该值default。

| 当将任务部署到多个平台时,任务的配置需要连接到与数据流服务器相同的数据库。 |

|---|

你可以配置本地运行的数据流服务器,以便将任务部署到 Cloud Foundry 或 Kubernetes。有关更多信息,请参见Cloud Foundry 任务平台配置和Kubernetes 任务平台配置部分。

在dataflow.spring.io (opens new window)上的对任务的多平台支持 (opens new window)一节中提供了跨多个平台启动和调度任务的详细示例。

# 开始船长

git clone https://github.com/spring-cloud/spring-cloud-skipper.git

cd spring-cloud/spring-cloud-skipper

./mvnw clean package -DskipTests=true

java -jar spring-cloud-skipper-server/target/spring-cloud-skipper-server-2.2.0.BUILD-SNAPSHOT.jar

# 启动 Spring 云数据流

git clone https://github.com/spring-cloud/spring-cloud-dataflow.git

cd spring-cloud-dataflow

./mvnw clean package -DskipTests=true

cd ..

创建一个包含以下内容的 YAML 文件 scdf.yml:

spring:

cloud:

dataflow:

security:

authorization:

provider-role-mappings:

uaa:

map-oauth-scopes: true

role-mappings:

ROLE_CREATE: foo.create

ROLE_DEPLOY: foo.create

ROLE_DESTROY: foo.create

ROLE_MANAGE: foo.create

ROLE_MODIFY: foo.create

ROLE_SCHEDULE: foo.create

ROLE_VIEW: foo.view

security:

oauth2:

client:

registration:

uaa:

redirect-uri: '{baseUrl}/login/oauth2/code/{registrationId}'

authorization-grant-type: authorization_code

client-id: dataflow

client-secret: dataflow

scope: (1)

- openid

- foo.create

- foo.view

provider:

uaa:

jwk-set-uri: http://uaa:8080/uaa/token_keys

token-uri: http://uaa:8080/uaa/oauth/token

user-info-uri: http://uaa:8080/uaa/userinfo (2)

user-name-attribute: user_name

authorization-uri: http://uaa:8080/uaa/oauth/authorize

resourceserver:

opaquetoken: (3)

introspection-uri: http://uaa:8080/uaa/introspect

client-id: dataflow

client-secret: dataflow

| 1 | 如果你使用作用域来标识角色,请确保还请求 相关的作用域,例如 dataflow.view,dataflow.create,并且不要忘记请求openid作用域 |

|---|---|

| 2 | 用于检索配置文件信息,例如用于显示目的的用户名(强制使用) |

| 3 | 用于令牌内省和验证(强制) |

当向 Spring 云数据流传递外部检索的(不透明的)OAuth 访问令牌时,introspection-uri属性尤其重要。 Spring 在这种情况下,云数据流将获取 OAuth 访问,并使用 UAA 的自检令牌端点 (opens new window)不仅检查令牌的有效性,而且还从 UAA 检索相关联的 OAuth 范围

最后启动 Spring 云数据流:

java -jar spring-cloud-dataflow/spring-cloud-dataflow-server/target/spring-cloud-dataflow-server-2.4.0.BUILD-SNAPSHOT.jar --spring.config.additional-location=scdf.yml

# 角色映射

默认情况下,所有角色都分配给登录到 Spring 云数据流的用户。但是,你可以设置属性:

spring.cloud.dataflow.security.authorization.provider-role-mappings.uaa.map-oauth-scopes: true

这将指示底层DefaultAuthoritiesExtractor将 OAuth 范围映射到相应的权限。支持以下范围:

范围

dataflow.create映射到CREATE角色范围

dataflow.deploy映射到DEPLOY角色范围

dataflow.destroy映射到DESTROY角色范围

dataflow.manage映射到MANAGE角色范围

dataflow.modify映射到MODIFY角色范围

dataflow.schedule映射到SCHEDULE角色范围

dataflow.view映射到VIEW角色

此外,你还可以将任意范围映射到每个数据流角色:

spring:

cloud:

dataflow:

security:

authorization:

provider-role-mappings:

uaa:

map-oauth-scopes: true (1)

role-mappings:

ROLE_CREATE: dataflow.create (2)

ROLE_DEPLOY: dataflow.deploy

ROLE_DESTROY: dataflow.destoy

ROLE_MANAGE: dataflow.manage

ROLE_MODIFY: dataflow.modify

ROLE_SCHEDULE: dataflow.schedule

ROLE_VIEW: dataflow.view

| 1 | 启用从 OAuth 范围到数据流角色的显式映射支持 |

|---|---|

| 2 | 当启用角色映射支持时,你必须为 所有 7 个 Spring 云数据流角色Cloud Foundry Deployer 属性,角色 _ 部署,角色 _destroy,角色 _ 管理,角色 _ 修改,角色 _ 日程安排提供映射。 |

| 你可以将 OAuth 范围分配给多个 Spring 云数据流角色,从而使你在授权配置的粒度方面具有灵活性。 |

|---|

# 10.6.4.LDAP 身份验证

LDAP 身份验证(轻量级目录访问协议)是由 Spring 云数据流使用的 UAA 间接提供的。UAA 本身提供全面的 LDAP 支持 (opens new window)。

| 虽然你可以使用自己的 OAuth2 身份验证服务器,但是这里记录的 LDAP 支持 需要使用 UAA 作为身份验证服务器。对于任何 其他提供者,请参阅该特定提供者的文档。 |

|---|

UAA 支持使用以下模式对 LDAP(轻量级目录访问协议)服务器进行身份验证:

| 当与外部身份提供程序(例如 LDAP)集成时,UAA 内的身份验证 变为锁链。UAA 首先尝试使用 用户的凭据,在外部提供者 ldap 之前对 UAA 用户存储区进行身份验证。有关更多信息,请参见用户帐户和身份验证 LDAP 集成Github 文档中的链式认证 (opens new window)。 |

|---|

# LDAP 角色映射

OAuth2 身份验证服务器(UAA)为将 LDAP 组映射到 OAuth 范围 (opens new window)提供了全面的支持。

存在以下备选方案:

ldap/ldap-groups-null.xml不会映射任何组ldap/ldap-groups-as-scopes.xml将从一个 LDAP 属性检索组名称。例如CNldap/ldap-groups-map-to-scopes.xml组将使用外部 _group_ 映射表映射到 UAA 组。

这些值是通过配置属性ldap.groups.file controls指定的。在封面下,这些值引用一个 Spring XML 配置文件。

| 在测试和开发过程中,可能需要对 LDAP 组和用户进行 的频繁更改,并查看反映在 UAA 中的更改。但是,用户secrets (opens new window)信息在登录期间被缓存。下面的脚本 有助于快速检索更新的信息: <br/>#!/bin/bash<br/>uaac token delete --all<br/>uaac target http://localhost:8080/uaa<br/>uaac token owner get cf <username> -s "" -p <password><br/>uaac token client get admin -s adminsecret<br/>uaac user get <username><br/> |

|---|

# LDAP 安全和 UAA 示例应用程序

为了快速启动和运行并帮助你了解安全架构,我们在 Github 上提供了LDAP 安全性和 UAA 示例 (opens new window)。

| 这只是一个演示/示例应用程序,不应在生产中使用。 |

|---|

该设置包括:

Spring 云数据流服务器

Skipper 服务器

CloudFoundry 用户帐户和认证(UAA)服务器

轻量级目录访问协议服务器(由Apache 目录服务器 (opens new window)提供)

最后,作为本示例的一部分,你将学习如何使用此安全设置配置和启动一个组合任务。

# 10.6.5. Spring 安全 OAuth2 资源/授权服务器示例

对于本地测试和开发,你还可以使用Spring Security OAuth (opens new window)提供的资源和授权服务器支持。它允许你使用以下简单的注释轻松地创建自己的(非常基本的)OAuth2 服务器:

@EnableResourceServer@EnableAuthorizationServer

| 实际上,UAA 使用了 Spring 安全 OAuth2 下的覆盖,因此基本端点 是相同的。 |

|---|

可以在以下位置找到一个工作示例应用程序:https://github.com/ghillert/oauth-test-server/ (opens new window)

复制该项目并配置 Spring 云数据流,其中包含相应的客户机 ID 和客户机秘密:

security:

oauth2:

client:

client-id: myclient

client-secret: mysecret

access-token-uri: http://127.0.0.1:9999/oauth/token

user-authorization-uri: http://127.0.0.1:9999/oauth/authorize

resource:

user-info-uri: http://127.0.0.1:9999/me

token-info-uri: http://127.0.0.1:9999/oauth/check_token

| 此示例应用程序不用于生产。 |

|---|

# 10.6.6.数据流壳身份验证

使用 shell 时,可以通过用户名和密码提供凭据,也可以通过指定凭据-提供者命令提供凭据。如果你的 OAuth2 提供程序支持密码grant 类型,那么你可以通过以下方式启动数据流壳:

$ java -jar spring-cloud-dataflow-shell-2.9.2.jar \

--dataflow.uri=http://localhost:9393 \ (1)

--dataflow.username=my_username \ (2)

--dataflow.password=my_password \ (3)

--skip-ssl-validation true \ (4)

| 1 | 可选的,默认为本地主机:9393 (opens new window)。 |

|---|---|

| 2 | 强制性的。 |

| 3 | 如果未提供密码,则会提示用户输入密码。 |

| 4 | 可选的,默认为false,忽略证书错误(当使用自签名证书时)。谨慎使用! |

| 请记住,当启用 Spring 云数据流的身份验证时,如果你想通过用户名/密码身份验证使用 shell,则底层的 OAuth2 提供者支持OAuth2grant 类型。 |

|---|

在 Data Flow 壳牌 中,你还可以使用以下命令提供凭据:

server-unknown:>dataflow config server \

--uri http://localhost:9393 \ (1)

--username myuser \ (2)

--password mysecret \ (3)

--skip-ssl-validation true \ (4)

| 1 | 可选的,默认为本地主机:9393 (opens new window)。 |

|---|---|

| 2 | 强制.. |

| 3 | 如果启用了安全性,但未提供密码,则会提示用户使用该密码。 |

| 4 | 可选的,忽略证书错误(当使用自签名证书时)。谨慎使用! |

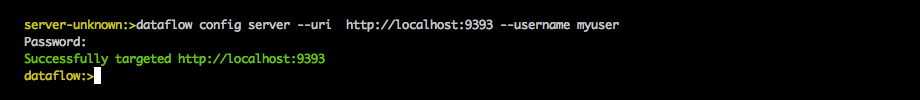

下图显示了连接到数据流服务器并对其进行身份验证的典型 shell 命令:

图 1.在 shell 中使用数据流服务器进行目标和身份验证

一旦成功锁定目标,你应该会看到以下输出:

dataflow:>dataflow config info

dataflow config info

╔═══════════╤═══════════════════════════════════════╗

║Credentials│[username='my_username, password=****']║

╠═══════════╪═══════════════════════════════════════╣

║Result │ ║

║Target │http://localhost:9393 ║

╚═══════════╧═══════════════════════════════════════╝

或者,你可以指定凭据-提供者命令,以便直接传入一个承载令牌,而不是提供用户名和密码。这可以在 shell 中进行,或者在启动 shell 时提供--dataflow.credentials-provider-command命令行参数。

| 当使用凭据-提供者命令时,请注意你的 指定命令必须返回一个不记名令牌(访问令牌前缀为承担者)。不记名令牌例如,在 UNIX 环境中,可以使用以下简单化命令: <br/>$ java -jar spring-cloud-dataflow-shell-2.9.2.jar \<br/> --dataflow.uri=http://localhost:9393 \<br/> --dataflow.credentials-provider-command="echo Bearer 123456789"<br/> |

|---|

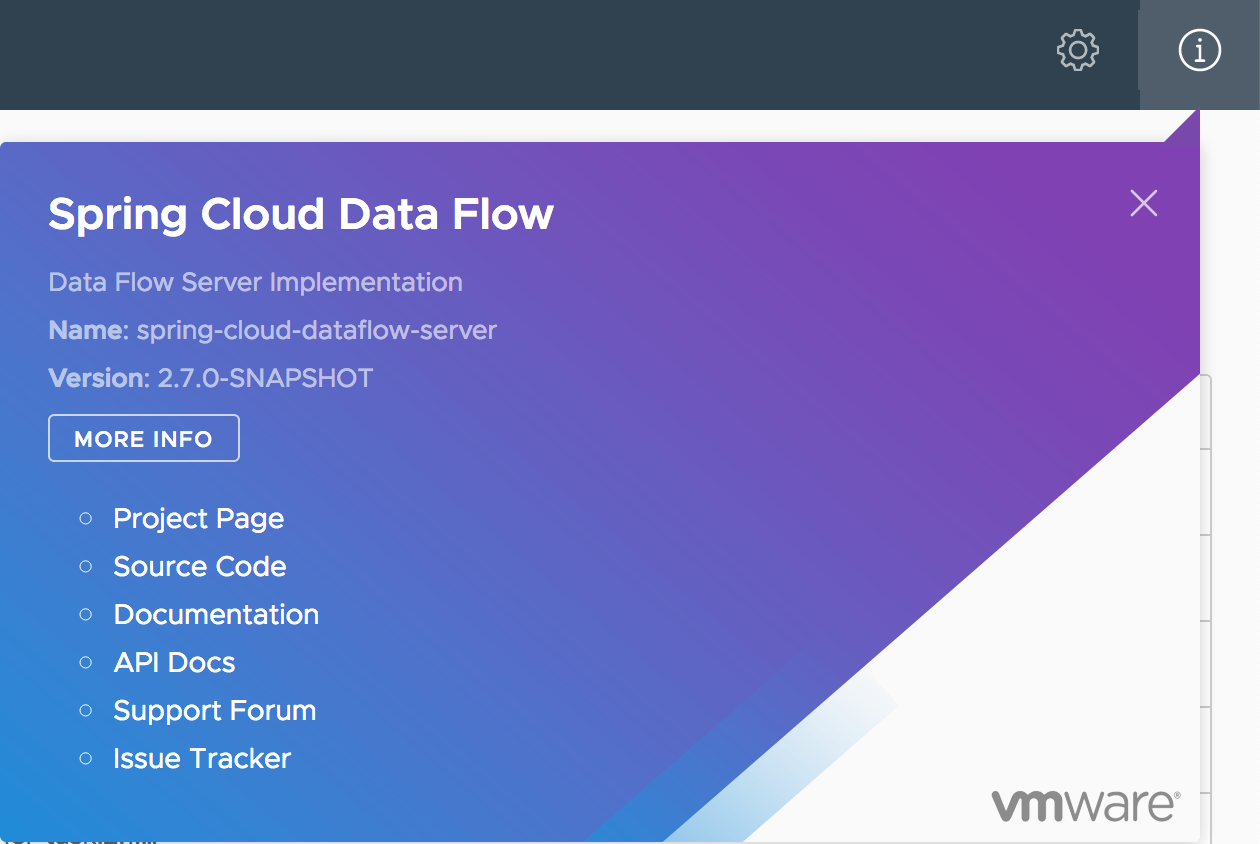

# 10.7.关于配置

Spring 关于 RESTful API 结果的云数据流包含显示名称、版本,以及(如果指定的话)用于构成 Spring 云数据流的每个主要依赖项的 URL。结果(如果启用)还包含 Shell 依赖项的 SHA1 和或 SHA256 校验和。通过设置以下属性,可以配置为每个依赖项返回的信息:

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-core.name:用于核心的名称。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-core.version:用于内核的版本。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-dashboard.name:用于仪表板的名称。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-dashboard.version:用于仪表板的版本。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-implementation.name:用于实现的名称。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-implementation.version:用于实现的版本。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-shell.name:用于 shell 的名称。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-shell.version:用于 shell 的版本。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-shell.url:用于下载 shell 依赖项的 URL。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-shell.checksum-sha1:与 shell 依赖项信息一起返回的 sha1 校验和值。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-shell.checksum-sha256:与 shell 依赖项信息一起返回的 sha256 校验和值。

Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-shell.checksum-sha1-url:如果没有指定

spring.cloud.dataflow.version-info.spring-cloud-dataflow-shell.checksum-sha1,SCDF 使用在此 URL 处指定的文件的内容进行校验和。Spring.cloud.dataflow.version-info. Spring-cloud-dataflow-shell.checksum-sha256-url:如果没有指定

port,SCDF 使用在此 URL 处指定的文件的内容进行校验和。

# 10.7.1.启用 shell 校验和值

默认情况下,不会为 shell 依赖项显示校验和值.如果需要启用此功能,请将spring.cloud.dataflow.version-info.dependency-fetch.enabled属性设置为 true。

# 10.7.2.为 URL 保留的值

你可以将保留的值(由花括号包围)插入到 URL 中,以确保链接是最新的:

存储库:如果使用构建快照、里程碑或数据流的候选版本,则存储库引用 repo- Spring-io 存储库。否则,它指的是 Maven central。

版本:插入 JAR/ POM 的版本。

例如,如果你使用 Spring 云数据流 shell 的 1.2.3.3.Release 版本,则[myrepository/org/springframework/cloud/spring-cloud-dataflow-shell/{version}/spring-cloud-dataflow-shell-{version}.jar](https://myrepository/org/springframework/cloud/spring-cloud-dataflow-shell/{version}/spring-cloud-dataflow-shell-{version}.jar)生成[myrepository/org/springframework/cloud/spring-cloud-dataflow-shell/1.2.3.RELEASE/spring-cloud-dataflow-shell-1.2.3.RELEASE.jar](https://myrepository/org/springframework/cloud/spring-cloud-dataflow-shell/1.2.3.RELEASE/spring-cloud-dataflow-shell-1.2.3.RELEASE.jar)

# 11. 配置-Cloud Foundry

本节描述了如何配置 Spring 云数据流服务器的特性,例如安全性和使用哪个关系数据库。它还描述了如何配置 Spring Cloud Data Flow Shell 的功能。

# 11.1.功能切换

Data Flow Server 提供了一组特定的特性,你可以在启动时启用或禁用这些特性。这些特性包括用于以下方面的所有生命周期操作和 REST 端点(服务器、客户端实现,包括 Shell 和 UI):

溪流

任务

在启动数据流服务器时,可以通过设置以下布尔属性来启用或禁用这些功能:

spring.cloud.dataflow.features.streams-enabledspring.cloud.dataflow.features.tasks-enabled

默认情况下,所有功能都已启用。

REST 端点(/features)提供有关已启用和已禁用功能的信息。

# 11.2.部署人员属性

你可以使用数据流服务器的Cloud Foundry 部署人员 (opens new window)的以下配置属性来定制应用程序的部署方式。在使用数据流壳层进行部署时,可以使用语法deployer.<appName>.cloudfoundry.<deployerPropertyName>。参见下面的 shell 用法示例。在配置数据流服务器中的Cloud Foundry 任务平台和 Skipper 中的 Kubernetes 平台以部署流时,也会使用这些属性。

| Deployer Property Name | 说明 | Default Value |

|---|---|---|

| services | 要绑定到已部署应用程序的服务的名称。 | <none> |

| host | 作为路由的一部分使用的主机名。 | hostname derived by Cloud Foundry |

| domain | 当映射应用程序的路由时要使用的域。 | <none> |

| routes | 应用程序应该绑定到的路由列表。与主机和域互斥。 | <none> |

| buildpack | 用于部署应用程序的 buildpack。不赞成使用构建包。 | github.com/cloudfoundry/java-buildpack.git#v4.29.1 (opens new window) |

| buildpacks | 用于部署应用程序的构建包列表。 | github.com/cloudfoundry/java-buildpack.git#v4.29.1 (opens new window) |

| memory | 要分配的内存量。默认单元是 mebibytes,支持“m”和“g”后缀 | 1024m |

| disk | 要分配的磁盘空间量。默认的单元是支持的 mebibytes、“m”和“g”后缀。 | 1024m |

| healthCheck | 在已部署的应用程序上执行的健康检查的类型。值可以是 HTTP、None、Process 和 Port | PORT |

| healthCheckHttpEndpoint | HTTP 健康检查将使用的路径, | /health |

| healthCheckTimeout | 健康检查的超时值(以秒为单位)。 | 120 |

| instances | 要运行的实例的数量。 | 1 |

| enableRandomAppNamePrefix | 标记,以启用在应用程序名称前加上一个随机前缀。 | true |

| apiTimeout | 用于阻止 API 调用的超时(以秒为单位)。 | 360 |

| statusTimeout | 状态 API 操作的超时(以毫秒为单位) | 5000 |

| useSpringApplicationJson | 标志,指示应用程序属性是被输入SPRING_APPLICATION_JSON还是作为单独的环境变量。 | true |

| stagingTimeout | 为安装应用程序分配的超时时间。 | 15 minutes |

| startupTimeout | 为启动应用程序分配的超时时间。 | 5 minutes |

| appNamePrefix | 用作已部署应用程序名称前缀的字符串 | The Spring Boot property spring.application.name of the application that is using the deployer library. |

| deleteRoutes | 在取消部署应用程序时是否也要删除路由。 | true |

| javaOpts | 要传递给 JVM 的 Java 选项,例如-dtest=foo | <none> |

| push任务Enabled | 是推送任务应用程序,还是假设应用程序在启动时已经存在。 | true |

| autoDeleteMavenArtifacts | 是否在部署时从本地存储库中自动删除 Maven 工件。 | true |

| env.<key> | 定义顶层环境变量。这对于自定义Java 构建包配置 (opens new window)非常有用,因为 Java 构建包不识别SPRING_APPLICATION_JSON,这些变量必须作为顶级环境变量包含在应用程序清单中。 | The deployer determines if the app has Java CfEnv (opens new window) in its classpath. If so, it applies the required configuration (opens new window). |

以下是使用 Cloud Foundry 部署属性的一些示例:

- 你可以设置用于部署每个应用程序的构建包。例如,要使用 Java 脱机 buildback,请设置以下环境变量:

cf set-env dataflow-server SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_DEPLOYMENT_BUILDPACKS java_buildpack_offline

现在不赞成设置

buildpack,而赞成buildpacks,它允许你在需要时传递多个参数。有关这方面的更多信息,请访问构建包如何工作 (opens new window)。你可以使用本地主机:9393 (opens new window)环境变量自定义 Cloud Foundry 使用的健康检查机制,以判断应用程序是否正在运行。当前支持的选项是

http(默认)、port和none。

你还可以分别设置指定基于 HTTP 的健康检查端点和超时的环境变量:SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_DEPLOYMENT_HEALTH_CHECK_TIMEOUT和SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_DEPLOYMENT_HEALTH_CHECK_TIMEOUT。这些默认值为/health( Spring 引导默认位置)和120秒。

- 你还可以通过使用 DSL 指定部署属性。例如,如果要将

http应用程序分配的内存设置为 512M,并将 MySQL 服务绑定到120应用程序,则可以运行以下命令:

dataflow:> stream create --name mysqlstream --definition "http | jdbc --tableName=names --columns=name"

dataflow:> stream deploy --name mysqlstream --properties "deployer.http.memory=512, deployer.jdbc.cloudfoundry.services=mysql"

| 你可以为流应用程序和任务应用程序分别配置这些设置。要更改任务的设置,请在属性名称中将 替换为 STREAM,如下例所示:<br/>cf set-env dataflow-server SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_DEPLOYMENT_MEMORY 512<br/> |

|---|

# 11.3.任务

数据流服务器负责部署任务。数据流启动的任务将其状态写入数据流服务器使用的同一数据库。对于 Spring 批处理作业的任务,作业和步骤执行数据也存储在该数据库中。与 Skipper 一样,任务可以在多个平台上启动。当数据流在 Cloud Foundry 上运行时,必须定义一个任务平台。要配置以 Cloud Foundry 为目标的新平台帐户,请在你的application.yaml文件中的spring.cloud.dataflow.task.platform.cloudfoundry节下通过另一种 Spring 启动支持的机制提供一个条目。在下面的示例中,创建了两个名为dev和qa的 Cloud Foundry 平台帐户。如memory和disk的键是Cloud Foundry Deployer 属性。

spring:

cloud:

dataflow:

task:

platform:

cloudfoundry:

accounts:

dev:

connection:

url: https://api.run.pivotal.io

org: myOrg

space: mySpace

domain: cfapps.io

username: [email protected]

password: drowssap

skipSslValidation: false

deployment:

memory: 512m

disk: 2048m

instances: 4

services: rabbit,mysql

appNamePrefix: dev1

qa:

connection:

url: https://api.run.pivotal.io

org: myOrgQA

space: mySpaceQA

domain: cfapps.io

username: [email protected]

password: drowssap

skipSslValidation: true

deployment:

memory: 756m

disk: 724m

instances: 2

services: rabbitQA,mysqlQA

appNamePrefix: qa1

通过将一个平台定义为platformName,你可以跳过使用platformName,否则将需要使用该平台。 |

|---|

启动任务时,使用 Task Launch 选项--platformName传递平台帐户名的值platformName如果不传递platformName的值,将使用该值default。

| 当将任务部署到多个平台时,任务的配置需要连接到与数据流服务器相同的数据库。 |

|---|

你可以将 Cloud Foundry 上的数据流服务器配置为将任务部署到 Cloud Foundry 或 Kubernetes。有关更多信息,请参见Kubernetes 任务平台配置一节。

在dataflow.spring.io (opens new window)上的对任务的多平台支持 (opens new window)一节中提供了跨多个平台启动和调度任务的详细示例。

# 11.4.应用程序名称和前缀

为了帮助避免在 Cloud Foundry 中与跨空间的路由发生冲突,可以使用一种命名策略,该策略为部署的应用程序提供一个随机的前缀,并且在默认情况下启用。你可以使用cf set-env命令重写cf set-env并设置相应的属性。

例如,如果你想禁用随机化,可以使用以下命令重写它:

cf set-env dataflow-server SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_DEPLOYMENT_ENABLE_RANDOM_APP_NAME_PREFIX false

# 11.5.自定义路线

作为随机名称的替代方法,或者为了更好地控制已部署应用程序所使用的主机名,你可以使用自定义部署属性,如下例所示:

dataflow:>stream create foo --definition "http | log"

sdataflow:>stream deploy foo --properties "deployer.http.cloudfoundry.domain=mydomain.com,

deployer.http.cloudfoundry.host=myhost,

deployer.http.cloudfoundry.route-path=my-path"

前面的示例将http应用程序绑定到[myhost.mydomain.com/my-path](https://myhost.mydomain.com/my-path)URL。注意,这个示例显示了全部的可用定制选项。在实践中,你只能使用三个中的一个或两个。

# 11.6.Docker 应用程序

从版本 1.2 开始,通过使用用于 Cloud Foundry 的数据流,可以注册和部署基于 Docker 的应用程序作为流和任务的一部分。

如果使用 Spring boot 和基于 RabbitMQ 的 Docker 映像,则可以提供一个公共部署属性,以方便将应用程序绑定到 RabbitMQ 服务。假设你的 RabbitMQ 服务名为rabbit,那么你可以提供以下内容:

cf set-env dataflow-server SPRING_APPLICATION_JSON '{"spring.cloud.dataflow.applicationProperties.stream.spring.rabbitmq.addresses": "${vcap.services.rabbit.credentials.protocols.amqp.uris}"}'

对于 Spring 云任务应用程序,如果使用名为mysql的数据库服务实例,则可以使用类似于以下内容的方法:

cf set-env SPRING_DATASOURCE_URL '${vcap.services.mysql.credentials.jdbcUrl}'

cf set-env SPRING_DATASOURCE_USERNAME '${vcap.services.mysql.credentials.username}'

cf set-env SPRING_DATASOURCE_PASSWORD '${vcap.services.mysql.credentials.password}'

cf set-env SPRING_DATASOURCE_DRIVER_CLASS_NAME 'org.mariadb.jdbc.Driver'

对于非 Java 或非引导应用程序,Docker 应用程序必须解析VCAP_SERVICES变量,才能绑定到任何可用的服务。

| 传递应用程序属性 当使用非引导应用程序时,你可能希望通过使用传统的 环境变量来传递应用程序属性,而不是使用特殊的 SPRING_APPLICATION_JSON变量。要做到这一点,请分别为流和任务设置以下变量: TRUST_CERTS |

|---|

# 11.7.应用程序级服务绑定

在 Cloud Foundry 中部署流时,你可以利用特定于应用程序的服务绑定,因此并不是所有服务都为 Spring 云数据流精心编制的所有应用程序进行了全局配置。

例如,如果你希望在以下流定义中仅为mysql应用程序提供jdbc服务绑定,则可以将服务绑定作为部署属性传递:

dataflow:>stream create --name httptojdbc --definition "http | jdbc"

dataflow:>stream deploy --name httptojdbc --properties "deployer.jdbc.cloudfoundry.services=mysqlService"

其中mysqlService是专门绑定到jdbc应用程序的服务的名称,而http应用程序不通过这种方法获得绑定。

如果有多个服务要绑定,则可以将它们作为逗号分隔的项传递(例如:deployer.jdbc.cloudfoundry.services=mysqlService,someService)。

# 11.8.配置服务绑定参数

CloudFoundry API 支持在绑定服务实例时提供配置参数。一些服务代理要求或推荐绑定配置。例如,使用 CF CLI 绑定谷歌云平台服务 (opens new window)看起来像是:

cf bind-service my-app my-google-bigquery-example -c '{"role":"bigquery.user"}'

同样,NFS 卷服务 (opens new window)支持绑定配置,例如:

cf bind-service my-app nfs_service_instance -c '{"uid":"1000","gid":"1000","mount":"/var/volume1","readonly":true}'

从版本 2.0 开始,Cloud Foundry 的数据流允许你提供绑定配置参数,可以在应用程序级别或服务器级别cloudfoundry.services部署属性中提供。例如,要绑定到 NFS 服务,如上所示:

dataflow:> stream deploy --name mystream --properties "deployer.<app>.cloudfoundry.services='nfs_service_instance uid:1000,gid:1000,mount:/var/volume1,readonly:true'"

该格式旨在与数据流 DSL 解析器兼容。通常,cloudfoundry.services部署属性接受以逗号分隔的值。由于逗号也用于分离配置参数,并避免空格问题,因此包括配置参数在内的任何项目都必须用单引号括起来。有效的价值包括:

rabbitmq,'nfs_service_instance uid:1000,gid:1000,mount:/var/volume1,readonly:true',mysql,'my-google-bigquery-example role:bigquery.user'

单引号中允许空格,并且可以使用=代替:来分隔键值对。 |

|---|

# 11.9.用户提供的服务

除了市场服务,Cloud Foundry 还支持用户提供的服务 (opens new window)。在整个参考手册中,都提到了常规服务,但也没有排除使用用户提供的服务,无论是作为消息传递中间件使用(例如,如果你想要使用外部的 Apache Kafka 安装)或某些流应用程序(例如,Oracle 数据库)使用。

现在,我们回顾一个从 UPS 提取和提供连接凭据的示例。

下面的示例显示了 Apache Kafka 的 UPS 设置示例:

cf create-user-provided-service kafkacups -p '{”brokers":"HOST:PORT","zkNodes":"HOST:PORT"}'

UPS 凭据被包装在VCAP_SERVICES中,并且可以直接在流定义中提供它们,如下例所示。

stream create fooz --definition "time | log"

stream deploy fooz --properties "app.time.spring.cloud.stream.kafka.binder.brokers=${vcap.services.kafkacups.credentials.brokers},app.time.spring.cloud.stream.kafka.binder.zkNodes=${vcap.services.kafkacups.credentials.zkNodes},app.log.spring.cloud.stream.kafka.binder.brokers=${vcap.services.kafkacups.credentials.brokers},app.log.spring.cloud.stream.kafka.binder.zkNodes=${vcap.services.kafkacups.credentials.zkNodes}"

# 11.10.数据库连接池

在 DataFlow2.0 中, Spring Cloud Connector 库不再用于创建数据源。现在使用的库java-cfenv (opens new window)允许你设置Spring Boot properties (opens new window)来配置连接池。

# 11.11.最大磁盘配额

默认情况下,Cloud Foundry 中的每个应用程序都从 1G 磁盘配额开始,并且可以将其调整为默认的最大 2G。通过使用 Pivotal Cloud Foundry 的 Ops Manager GUI,默认的最大值也可以覆盖到 10G。

这种配置与 Spring 云数据流相关,因为每个任务部署都由应用程序(通常是 Spring 引导 UBER-JAR 的)组成,并且这些应用程序是从远程 Maven 存储库解析的。在解析之后,应用程序工件被下载到本地 Maven 存储库以进行缓存和重用。当这种情况发生在后台时,默认磁盘配额(1G)可以迅速填充,特别是当我们实验由独特的应用程序组成的流时。为了克服这种磁盘限制,并根据你的缩放要求,你可能希望将默认的最大值从 2G 更改为 10G。让我们回顾一下更改默认的最大磁盘配额分配的步骤。

# 11.11.1.PCF 的运营经理

从 PCF 的 Ops Manager 中,选择“Pivotal Elastic Runtime”贴片并导航到“Application Developer Control”选项卡。将“每个应用程序的最大磁盘配额”设置从 2048(2G)更改为 10240(10G)。保存磁盘配额更新,并单击“应用更改”以完成配置覆盖。

# 11.12.规模应用

一旦成功应用了磁盘配额更改,并假设你有正在运行的应用程序,就可以通过 CF CLI 使用新的disk_limit扩展应用程序,如下例所示:

→ cf scale dataflow-server -k 10GB

Scaling app dataflow-server in org ORG / space SPACE as user...

OK

....

....

....

....

state since cpu memory disk details

#0 running 2016-10-31 03:07:23 PM 1.8% 497.9M of 1.1G 193.9M of 10G

然后,你可以列出应用程序并查看新的最大磁盘空间,如下例所示:

→ cf apps

Getting apps in org ORG / space SPACE as user...

OK

name requested state instances memory disk urls

dataflow-server started 1/1 1.1G 10G dataflow-server.apps.io

# 11.13.管理磁盘使用

即使在配置数据流服务器使用 10G 空间时,也有可能耗尽本地磁盘上的可用空间。为了防止这种情况,从外部来源下载的jar工件,即注册为http或maven资源的应用程序,在部署应用程序时会自动删除,无论部署请求是否成功。对于容器运行时稳定性比部署期间产生的 I/O 延迟更关键的生产环境,这种行为是最优的。在开发环境中,部署发生得更频繁。此外,jar工件(或打火机metadataJAR)包含描述应用程序配置属性的元数据,这些元数据用于与应用程序配置相关的各种操作,这些操作在生产前活动期间更频繁地执行(有关详细信息,请参见应用程序元数据 (opens new window))。为了提供响应更快的交互式开发人员体验,而不是在预生产环境中使用更多的磁盘,你可以将 CloudFoundry 部署程序属性autoDeleteMavenArtifacts设置为false。

如果使用默认的port健康检查类型部署数据流服务器,则必须显式地监视服务器上的磁盘空间,以避免耗尽空间。如果你使用http健康检查类型来部署服务器(请参见下一个示例),那么如果磁盘空间较低,则将重新启动数据流服务器。这是由于 Spring boot 的磁盘空间健康指示器 (opens new window)。通过使用带有management.health.diskspace前缀的属性,可以configure (opens new window)磁盘空间健康指示器的设置。

对于版本 1.7,我们正在研究使用批量服务 (opens new window)来使数据流服务器存储.jar工件,然后将它们推送到 Cloud Foundry。

下面的示例展示了如何将http健康检查类型部署到一个名为/management/health的端点:

---

...

health-check-type: http

health-check-http-endpoint: /management/health

# 11.14.应用解决方案

尽管我们建议对应用程序注册一个流应用程序使用 Maven artifactory,但在某些情况下,以下一种替代方法可能是有意义的。

我们定制并维护了一个SCDF 应用程序工具 (opens new window),它可以在 Cloud Foundry 中作为常规 Spring 启动应用程序运行,但它将在运行时为 SCDF 托管和服务应用程序 JAR。

在 Spring Boot 的帮助下,我们可以在 Cloud Foundry 中服务静态内容 (opens new window)。 Spring 一个简单的引导应用程序可以捆绑所有所需的流和任务应用程序。通过让它在 Cloud Foundry 上运行,静态应用程序就可以为 über-Jar 服务了。例如,可以通过使用

--uri=http://<Route-To-StaticApp>/http-source.jar在 shell 中注册名称为http-source.jar的应用程序。über-Jar 可以托管在任何可以通过 HTTP 访问的外部服务器上。它们也可以从原始的 GitHub URI 中解决。从 shell 中,你可以使用

--uri=http://<Raw_GitHub_URI>/http-source.jar注册名称为http-source.jar的应用程序。静态构建包 (opens new window)支持 Cloud Foundry 是另一种选择。类似的 HTTP 解析也适用于此模型。

批量服务 (opens new window)是另一个不错的选择。所需的 über-jars 可以托管在外部文件系统中。例如,在卷服务的帮助下,你可以使用

--uri=file://<Path-To-FileSystem>/http-source.jar以http-source.jar的名称注册应用程序。

# 11.15.安全

默认情况下,数据流服务器是不安全的,并在未加密的 HTTP 连接上运行。你可以通过启用 HTTPS 并要求客户机进行身份验证来保护 REST 端点(以及数据流仪表板)。有关保护 REST 端点和配置以针对 OAuth 后端(运行在 Cloud Foundry 上的 UAA 和 SSO)进行身份验证的更多详细信息,请参见核心[[configuration-local-security]](#configuration-local-security)中的安全部分。你可以在dataflow-server.yml中配置安全细节,或者通过cf set-env命令将它们作为环境变量传递。

# 11.15.1.认证

Spring 云数据流既可以与 Pivotal 单点登录服务(例如,在 PWS 上)集成,也可以与 Cloud Foundry 用户帐户和认证(UAA)服务器集成。

# 关键的单点登录服务

Spring 将云数据流部署到 Cloud Foundry 时,可以将应用程序绑定到关键的单点登录服务。通过这样做, Spring 云数据流利用了Java CFEnv (opens new window),后者为 OAuth2.0 提供了特定于云 Foundry 的自动配置支持。

为此,将 Pivotal 单点登录服务绑定到数据流服务器应用程序,并提供以下属性:

SPRING_CLOUD_DATAFLOW_SECURITY_CFUSEUAA: false (1)

SECURITY_OAUTH2_CLIENT_CLIENTID: "${security.oauth2.client.clientId}"

SECURITY_OAUTH2_CLIENT_CLIENTSECRET: "${security.oauth2.client.clientSecret}"

SECURITY_OAUTH2_CLIENT_ACCESSTOKENURI: "${security.oauth2.client.accessTokenUri}"

SECURITY_OAUTH2_CLIENT_USERAUTHORIZATIONURI: "${security.oauth2.client.userAuthorizationUri}"

SECURITY_OAUTH2_RESOURCE_USERINFOURI: "${security.oauth2.resource.userInfoUri}"

| 1 | 重要的是,将属性spring.cloud.dataflow.security.cf-use-uaa设置为false |

|---|

对于非云计算代工安全场景,也同样支持授权。请参阅核心数据流[[configuration-local-security]]中的安全部分。

由于角色的配置在不同的环境中可能会有很大的差异,因此默认情况下,我们将所有 Spring 云数据流角色分配给用户。

你可以通过提供自己的[AuthoritiesExtractor](https://DOCS. Spring.io/ Spring-boot/DOCS/current/api/org/springframework/boot/autofigure/security/oAututh2/resource/authoritiesextractor.html)来定制这种行为。

下面的示例显示了一种可能的方法,用于在UserInfoTokenServices上设置自定义AuthoritiesExtractor:

public class MyUserInfoTokenServicesPostProcessor

implements BeanPostProcessor {

@Override

public Object postProcessBeforeInitialization(Object bean, String beanName) {

if (bean instanceof UserInfoTokenServices) {

final UserInfoTokenServices userInfoTokenServices == (UserInfoTokenServices) bean;

userInfoTokenServices.setAuthoritiesExtractor(ctx.getBean(AuthoritiesExtractor.class));

}

return bean;

}

@Override

public Object postProcessAfterInitialization(Object bean, String beanName) {

return bean;

}

}

然后,你可以在你的配置类中声明它,如下所示:

@Bean

public BeanPostProcessor myUserInfoTokenServicesPostProcessor() {

BeanPostProcessor postProcessor == new MyUserInfoTokenServicesPostProcessor();

return postProcessor;

}

# Cloud Foundry UAA

Cloud Foundry 用户帐户和身份验证(UAA)的可用性取决于 Cloud Foundry 环境。为了提供 UAA 集成,你必须提供必要的 OAuth2 配置属性(例如,通过设置SPRING_APPLICATION_JSON属性)。

下面的 JSON 示例展示了如何创建安全配置:

{

"security.oauth2.client.client-id": "scdf",

"security.oauth2.client.client-secret": "scdf-secret",

"security.oauth2.client.access-token-uri": "https://login.cf.myhost.com/oauth/token",

"security.oauth2.client.user-authorization-uri": "https://login.cf.myhost.com/oauth/authorize",

"security.oauth2.resource.user-info-uri": "https://login.cf.myhost.com/userinfo"

}

默认情况下,spring.cloud.dataflow.security.cf-use-uaa属性设置为true。此属性激活一个特殊的[AuthoritiesExtractor](https://DOCS. Spring.io/ Spring-boot/DOCS/current/api/org/springframework/boot/autofigure/security/oauth2/resource/authoritiesextractor.html),该函数称为CloudFoundryDataflowAuthoritiesExtractor。

如果不使用 CloudFoundry UAA,则应将spring.cloud.dataflow.security.cf-use-uaa设置为false。

在这种情况下,spring.cloud.dataflow.security.cf-use-uaa会调用Cloud Foundry Apps API (opens new window),并确保用户实际上是空间开发人员。

如果已验证的用户被验证为空间开发人员,则将分配所有角色。

# 11.16.配置参考

你必须提供几个配置部分。这些是 Spring boot@ConfigurationProperties,因此你可以将它们设置为环境变量,或者通过 Spring boot 支持的任何其他方式。下面的列表是环境变量格式,因为这是在 Cloud Foundry 中开始配置引导应用程序的一种简单方法。请注意,在将来,你将能够将任务部署到多个平台,但是对于 2.0.0.m1,你只能部署到一个平台,并且名称必须是spring.cloud.dataflow.security.cf-use-uaa。

# Default values appear after the equal signs.

# Example values, typical for Pivotal Web Services, are included as comments.

# URL of the CF API (used when using cf login -a for example) - for example, https://api.run.pivotal.io

SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_CONNECTION_URL=

# The name of the organization that owns the space above - for example, youruser-org

SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_CONNECTION_ORG=

# The name of the space into which modules will be deployed - for example, development

SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_CONNECTION_SPACE=

# The root domain to use when mapping routes - for example, cfapps.io

SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_CONNECTION_DOMAIN=

# The user name and password of the user to use to create applications

SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_CONNECTION_USERNAME=

SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_CONNECTION_PASSWORD

# The identity provider to be used when accessing the Cloud Foundry API (optional).

# The passed string has to be a URL-Encoded JSON Object, containing the field origin with value as origin_key of an identity provider - for example, {"origin":"uaa"}

SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_CONNECTION_LOGIN_HINT=

# Whether to allow self-signed certificates during SSL validation (you should NOT do so in production)

SPRING_CLOUD_DATAFLOW_TASK_PLATFORM_CLOUDFOUNDRY_ACCOUNTS[default]_CONNECTION_SKIP_SSL_VALIDATION

# A comma-separated set of service instance names to bind to every deployed task application.